-

Postów

54 -

Dołączył

-

Ostatnia wizyta

Ostatnie wizyty

521 wyświetleń profilu

Osiągnięcia WebCM

Zielony (2/5)

17

Reputacja

-

A już myślałem, że temat umarł. Może trzeba stworzyć osobny dział Rowery na forum tak jak na PCLab? Przyjemnie jedzie się po świeżo nasypanym śniegu. Uwierzyłem prognozom pogody, że nie będzie sypać i nie wziąłem okularów. 🤓 Podsumowanie: dystans - 8 991 km wspinaczka - 71 488 m czas - 420 godzin najdłuższa trasa - 135 km / 2500 m Rowery: szosa - 4850 km full - 500 km sztywniaki - pozostałe Co nowego: Pomiar mocy w ramionach korby. Czy rzetelnie pokazuje, trudno powiedzieć, bo odnoszę wrażenie, że czasami są to losowe wartości. Radar Garmin Varia. Największa wada to krótko trzyma na baterii. Sterowanie światłami z komputerka działa tak sobie, a często muszę od nowa parować osobno światło i radar. Na początku wykrywa tylne koło, ale po pewnym czasie przestaje. Czy przydatny gadżet? Byłem sceptyczny, ale przynajmniej widzisz, jak blisko ciebie są samochody i kiedy chcą cię wyprzedzić bez odwracania się. Poza tym bez zmian. Plany na kolejny rok: 10 000 km poprawić wyniki nowe koła do szosy (może coś polecacie) nowe ciuszki i bardziej dopasowane buty zaliczyć więcej ciekawych miejsc rowerem

-

Ciężkie egzystencjalne rozkminy, czyli jak podejść do zakupu mieszkania?

WebCM odpowiedział(a) na Zas temat w Dyskusje na tematy różne

Dlaczego nie wyrabiasz psychicznie? To ruletka. Dziś fryzjer, jutro kebab. Na grupach ludzie z tego samego pionu skarżą się, że leci im smród do mieszkań. Celuj w nowe budownictwo. Jeśli garaż podziemny spełnia normy ppoż., to nie bałbym się elektryków. Wielka płyta tylko wtedy, jeśli zależy ci na lokalizacji. Nie warto pakować pieniędzy w remont generalny. Masz na oku konkretne mieszkanie? Jeśli nie masz takiej potrzeby, to nie pchaj się w duży metraż. Mniejsze mieszkanie potem łatwiej sprzedasz. Finalnie liczy się: cena mieszkania (nie kupuj pod korek) wysokość rat (oprocentowane może się zmieniać) czynsz do spółdzielni (od metrażu i liczby lokatorów) układ pomieszczeń (jeśli coś jest nie tak, to nie kupuj) Jeśli bardzo ci zależy, to miejsce w garażu kup później, pożycz kasę, pochodź po różnych bankach, negocjuj z deweloperem, może część daj pod stołem. To jest najgorsze, ale czasami warto poczekać. Alkoholizm i patologia to duży problem na starych osiedlach, natomiast na deweloperce często są głośne imprezy do 5 rano. Jeśli osiedle jest dobrze skomunikowane, jest blisko do centrum i są wokół sklepy, usługi, przystanki, to rozważ WP. Jeśli to obrzeża, to odpuść. Ciężko jest z terminami, ale jeśli się nie znasz i nie masz czasu, to brałbym kompleksową usługę. Szkoda kasy na remont generalny, chyba że ci mocno zależy, aby mieszkać nowocześnie, ale moda co jakiś czas się zmienia i nie warto podążać za tiktokowymi trendami. Kto choć raz miał przyjemność pracować w salonie z aneksem, to docenia osobną kuchnię. Moc taka sama powinna być. Nie wymienisz w okresie grzewczym, bo jest inny rozstaw rurek. Zapomnij o efektywnym zbiorkomie na obrzeżach. Chyba że to Warszawa i masz dostęp do metra. Ścisk, przesiadki, opóźnienia, sauna w zimie, awantury, uciążliwi pasażerowie, to nie dla mnie. Alternatywą jest rower lub hulajnoga, także w zimie. 1 km do najbliższego przystanku to za dużo. Celuj w centrum i samowystarczalne osiedla. -

Polećcie dobry zestaw odzieży na szosę na jesień i zimę. Dopóki temperatury będą powyżej 0°C, to będę jeździć na zewnątrz. W tym roku idę na rekord.

-

Ale prace nad komputerami kwantowymi trwają i cały czas jest co badać. Zacząłem się interesować tematem. No wiem, że będzie ciężko, dlatego ten temat, czy ktoś robił doktorat w tym trybie lub zna kogoś, kto robił. Jak się nie uda na normalnych uczelniach, to mogę spróbować na jakiejś prywatnej, gdzie bardziej na luzie do tego podchodzą. Najpierw mam w planach przejść jeszcze raz materiał ze studiów, pokończyć projekty, chociaż ostatnio oglądałem film, gdzie pewien doktorant radzi, aby najpierw znaleźć temat, a potem uczyć się tego, co potrzebne, podobnie jak na etacie realizujemy projekty. Do obliczeń kwantowych trzeba umieć macierze. Miałem iść od razu na III stopień, ale studia nie wystartowały ze względu na małą liczbę chętnych. Potem nie wracałem do tematu. Wszystko kręciło się wokół etatu i sportu. Jednak ciągnie mnie do nauki i chcę dokończyć temat. U mnie w robocie ludzie narzekają "jesteśmy tylko CRUD-ziarzami". Ja chcę się z tego wyrwać, ale na razie nie rzucać etatu, dlatego tryb z wolnej stopy dla mnie będzie najlepszy. A jak nie, to mogę iść do szkoły doktorskiej, ale bez prowadzenia zajęć ze studentami i tu też się zastanawiam, na ile to jest obligatoryjne. W ogóle to można skończyć jako asystent do roboty papierkowej, stracić mnóstwo czasu i przed tym przestrzegają. Dlatego lepiej z wolnej stopy.

-

Stary komputer nieużywany kilka lat - ryzyka

WebCM odpowiedział(a) na WebCM temat w Dyskusje na tematy różne

Na YouTube pełno wybuchających zasilaczy. A temat założyłem po to, że na pewno dużo osób ma tutaj stare komputery i czy coś się z nimi działo po dłuższej przerwie. Prawdopodobnie wszystko będzie dalej działać. Chociaż to epoka, która słynęła z wadliwych kondensatorów. Pewnym ryzykiem jest, że komputer obudowany w biurku. Skoro mówicie, że ryzyko jest niskie, to można zaryzykować bez wyciągania. -

Stary komputer nieużywany kilka lat - ryzyka

WebCM odpowiedział(a) na WebCM temat w Dyskusje na tematy różne

Jutro tam będę i chcę się przygotować na ewentualne problemy. Modele językowe przewidują różne scenariusze. Grok DeepSeek Kondensatory się starzeją i to fakt, być może lepiej nie ryzykować ze starym PSU, ale chciałbym się oprzeć na waszych doświadczeniach. Bo jak pamiętam te 6-7 lat temu nie było żadnych problemów z zasilaczem. Zdarzało się, że BIOS widział procesor jako Duron, dostępne w BIOS-ie taktowania były znacznie niższe i pomagało wtedy wyłączenie komputera i włączenie go za chwilę, ale czy to wina starej elektroniki? No i tu kolejny raz o skąpstwie. Męczyłem się na tym sprzęcie przez całe liceum. Spokojnie do 2-3 kafli w tamtych czasach można było kupić sprzęt na Core2Duo. No ale nie, bo po co mi nowy komputer? Dopiero na studiach dostałem laptopa i to był potężny przeskok (choć praca na laptopie nie jest tak wydajna jak na stacjonarce). Generalnie pytanie, na ile to bezpieczne wcisnąć POWER, bo komputer obudowany w biurku i ciężki dostęp jest do niego. Oczywiście mogę wszystko odpiąć, wyjąć, dokonać inspekcji, przeczyścić, nawet wymienić pastę (kiedyś po 2 latach pewien "znawca" wymieniał i zepsuł), ale jest z tym trochę zabawy. Jeśli ruszy, to mogą wiatraki brzęczeć. Są w sumie 3 - w zasilaczu, na CPU i na GPU (wymieniany). W niedzielę i tak nic nie zrobię, jeśli by wyszły problemy, bo sklepy zamknięte. -

Jest taki komputer: Athlon 2000+ 512 MB RAM (dawniej 256 MB) karta GeForce4 chyba MX440 płyta K7S5A dysk 40 GB obudowa NTT System zakup 2003 lub 2004 rok ostatnio uruchamiany 2018 lub 2019 rok ostatnio czyszczony między 2010-2015 nic niewymieniane oprócz wiatraka na grafice cały czas podpięty do prądu Czy można bezpiecznie odpalać ten komputer, czy są jakieś ryzyka? Najbardziej zależy mi na danych.

-

Czy ktoś ma z tym jakieś doświadczenia? Ten tryb jest o tyle fajny, że nie trzeba prowadzić zajęć ze studentami, tylko sam zajmujesz się pracą badawczą pod opieką promotora. Ostatnio trochę się pozmieniało. Kiedyś były studia III stopnia, a teraz są szkoły doktorskie i musisz się obronić w ciągu 4 lat. Jeśli się nie obronisz w terminie, to przechodzisz w tryb wolnej stopy i sam płacisz za wszczęcie postępowania o nadanie stopnia doktora. W przypadku doktoratu z wolnej stopy nie ma limitu czasu, a wniosek można złożyć w dowolnym momencie życia. Wcześniej składa się wniosek o wyznaczenie promotora. Ale jak to wygląda w rzeczywistości? Czy promotorzy godzą się na taką współpracę? Gdzie najłatwiej się dostać? A może nie tylko najłatwiej, bo żeby potem papier miał jakąś wartość i żeby promotor faktycznie miał aktualną wiedzę? Chociaż nie wiem, czy na to liczyć na polskich uczelniach. Tematyka to być może uczenie maszynowe, obliczenia kwantowe, ale szukając pomysłu może znajdę jakiś problem ludzkości do rozwiązania. https://www.gov.pl/web/nauka/ksztalcenie-doktorantow https://www.gov.pl/web/nauka/konstytucja-dla-nauki-2 Jak się przygotować? Zanim zacznę, to chyba wezmę literaturę z dobrych studiów i przerobię we własnym zakresie. Potem warto spróbować pisać własne publikacje i będzie karta przetargowa, aby się dostać na lepszą uczelnię. A czy warto iść na jakieś podyplomowe (niekoniecznie w PL, może być za granicą lub online) lub zrobić kursy (jakie mają uznanie?), aby nadrobić zaległości i poszerzyć wiedzę z wybranych zagadnień (np. algorytmy uczenia, szyfrowania, fizyka kwantowa, bo to się będzie rozwijać)?

-

Chyba zdecyduję się na Kukirin. Ludzie najczęściej skarżą się, że bateria nie wytrzymuje długo. Co więcej, ten sam model może różnić się w zależności od kanału dystrybucji i jaka fabryka montuje. Nie wiesz, co dostaniesz w środku. Ciekawie wyglądają nowe Techlife z literką Q, odchudzone do 30 kg. Wysoka półka to Hiley, Vsett, Kaboo, Dualtron, jednak swoje kosztują i waga często przekracza 30 kg. Szykują się nowe premiery, które mają być zgodne z polskimi przepisami. I tutaj mam wątpliwości. Nagonka na hulajnogi trwa, nasi sąsiedzi dokręcają śrubę i w Polsce też zamiast liberalizacji możemy spodziewać się zaostrzenia prawa, np. nie będzie można jeździć hulajnogami o mocy wyższej niż 500 W. Hulajnoga musi mieć zablokowaną konstrukcyjnie prędkość do 20 km/h. Co to znaczy "konstrukcyjnie"? Policja sprawdza w Internecie parametry hulajnogi i na tej podstawie konfiskuje sprzęt. Nie ma jeszcze orzeczenia sądu, czy wystarczy programowy ogranicznik. Jeśli nie, to legalne są tylko Xiaomi i wszystkie inne, gdzie ograniczenie jest sprzętowe i nie da się go obejść programowo. Z typowo miejskich hitem jest Segway MAX G3 z wbudowaną nawigacją. Widziałbym coś takiego w wypożyczanych. Na razie rozejrzę się na Kukirinami. Dobrze by się przejechać przed zakupem.

-

Co polecacie w 2025 roku? Zdecydowałem się na zakup własnej hulajnogi. Cel to dojazd do biura, zakupy i rekreacja. Chcę, aby dało się w miarę szybko i bezpiecznie gdzieś dojechać. Ostatnio w mieście połowa to Kukirin, ale opinie są zróżnicowane. Rozważam jeszcze Techlife i inne marki. Różnica jest taka, że w Techlife gaz jest przy prawym hamulcu. Czy to wygodniejsze od manetki na kciuk przy większych prędkościach? Jestem przyzwyczajony do kciuka. Wymagania: duży zasięg szeroki podest (większość już ma, ale im szerzej, tym lepiej) jeśli jest amortyzacja, to prawdziwa, z opcją regulacji, a nie imitacja panic button lub inny bezpiecznik (np. pokazuje 20 km/h, a jedzie 30 km/h) i tak to nic nie da komfort i odpowiednie wyważenie (bez uczucia katapultowania) lokalizator GPS na wypadek kradzieży i łatwe przypięcie bezpieczna bateria nowe: opony bezdętkowe Kukirin lub Kamikaze to dobra opcja? Co jeszcze polecacie? Które konkretnie modele? Jeśli wyjdzie, że będę stać w domu, to najwyżej odsprzedam. Z tego, co piszą ludzie na grupach, to szybko zużywają się łożyska w kołach. Niska cena nie bierze się znikąd.

-

Oto moje podsumowanie: Dystans: 5600 km Przewyższenie: 34000 m Czas: 350 godzin Najdłuższa trasa: 130 km Co jakim rowerem, to na oko: 2800 km crossem (głównie szutry i asfalty) 2500 km góralem (większość po mieście) 300 km fullem (góry i treningi w terenie) Co było nowego: Kupiłem licznik. W końcu mogę cały czas obserwować parametry bez obawy, że za chwilę padnie bateria. Wcześniej nie dało się jeździć dłuższych tras bez power banka, zwłaszcza w zimie. Niestety, nawigacja wciąż jest lepsza w telefonie. Komputerek gubi się w gęstym lesie, gdzie ścieżki biegną koło siebie. Może niedługo pojawi się sprzęt łączący funkcjonalność aplikacji na telefon, niskie zużycie energii licznika oraz łączność ze światem, by nie wozić dwóch urządzeń. Takie próby już były, ale okazało się, że obsługa sieci komórkowej zużywa dużo energii i trudniej przewidzieć pozostały czas pracy na baterii (jak jest słaby sygnał np. w górach, to urządzenie musi nadawać mocniej). Niemniej jednak to był udany zakup. Kiedy się zgubię, to w urządzeniu jest dużo miejsc, do których mogę nawigować, np. stacje PKP. Brakuje mi ETA z OSMAnd (szacowany czas dojazdu), by ocenić, czy zdążę na pociąg. Więcej jazd po górach. Nasze polskie góry są naprawdę piękne. Więcej tras długodystansowych 80-100 km (wytrzymałość tlenowa). Słabo przetrenowałem zimę i wiosna była ciężka. Dużo górek podchodziłem. W tygodniu rzadko po godzinach wychodziłem na trening. Nie mam już tak dużej motywacji jak dawniej. Wolę ten czas poświęcić na dokształcanie. Jak się w tygodniu zajedziesz, to na maratonach i ustawkach możesz nie mieć siły i zmagać się z DOMS, bo to już przerabiałem. Cele na 2025: Lepiej przygotować się do sezonu (solidnie przetrenować zimę) Poprawić technikę (zwłaszcza na zjazdach i technicznych odcinkach) Zwiększyć dystans i zwiedzić ciekawe miejsca (jeśli będzie wolny czas) Kupić szosę (ale obserwując to środowisko, mam poważne wątpliwości) Wytrwać w postanowieniach W zimie albo treningi na zewnątrz, albo przekonam się do trenażera. Poza tym inne aktywności (basen, bieganie, siłownia). Wszystko minimalnym kosztem, bo nie mogę całego wolnego czasu przepalić na sport. Zastanawiam się nad trenerem, bo ktoś mnie musi pilnować i motywować do treningu, aby na wiosnę mieć wypracowaną formę i nie zdychać na pierwszym podjeździe.

-

Zestaw do programowania, foto/wideo i sztucznej inteligencji

WebCM odpowiedział(a) na WebCM temat w Zestawy komputerowe

Poczytałem trochę i opcje są dwie: 1. Złożyć teraz sprzęt na Intel Core Ultra - który w testach w programach wypada przyzwoicie, ma świetny układ graficzny i Quick Sync, zużywa mniej energii w idle, ale nie nadaje się do gier 2. Poczekać na procesory AMD Ryzen 9900X3D i 9950X3D - lepiej nadają się do AI oraz do gier, podobno mają przewyższyć parametrami serię Threadripper - ale ciekawe, jaka będzie cena i użycie energii w idle (AMD nic nie robi, by obniżyć prądożerność na najniższym taktowaniu) https://www.pugetsystems.com/labs/articles/amd-ryzen-7-9800x3d-content-creation-review/ https://www.pugetsystems.com/labs/articles/intel-core-ultra-200s-content-creation-review/ Nie mogę znaleźć rzetelnych testów, jak jest z temperaturami i zużyciem energii podczas normalnej pracy, czyli piszesz kod w IntelliJ, czytasz coś, masz odpalone emulatory i kontenery, kompilujesz/budujesz kod na bieżąco, bo tym będę się zajmował najwięcej. Tutaj każdy procesor styknie, ale można natrafić na artykuły, że Intel będzie podczas takiej pracy zużywał mniej energii (mniejsze idle, podobne TDP). Jeśli chodzi o edycję wideo, większość programów oprócz DaVinci lepiej radzi sobie na Intelu. Do codziennej pracy zewnętrzną grafikę można wyłączyć, to użycie energii jeszcze spadnie. A wszystko ma podrożeć po Nowym Roku. Wyjątkiem jest AI, gdzie procesory AMD ze swoją architekturą 3D i większym cache biją Intela (ale i tak większość robi się na kartach graficznych). Nie wiem, czy znajdę czas na zabawy z AI, więc nie jest to priorytet. W sklepie sprzedawca też stwierdził, że do pracy Intel, a do gier AMD. Jak ktoś ma porównanie lub zobaczy jakiś fajny test, to niech wklei linka. Poczekam jeszcze na premierę nowych Ryzenów i wtedy podejmę ostateczną decyzję. Co do reszty podzespołów, to mam zapisane propozycje i po wyborze CPU podam konfigurację. Edit: a czy nie wystarczyłoby wyłączać zbędnych rdzeni i włączać tylko wtedy, gdy potrzebujemy więcej mocy? Które procesory to umożliwiają? -

📝 Instrukcja wykonywania kopii zapasowej tematów z Forum PCLab.pl

WebCM odpowiedział(a) na Filip454 temat w Dyskusje na tematy różne

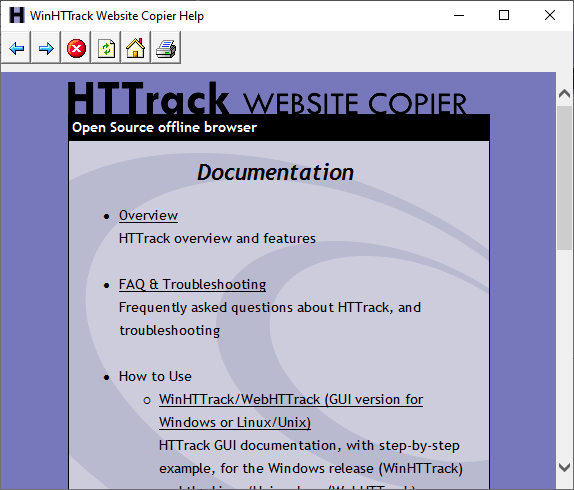

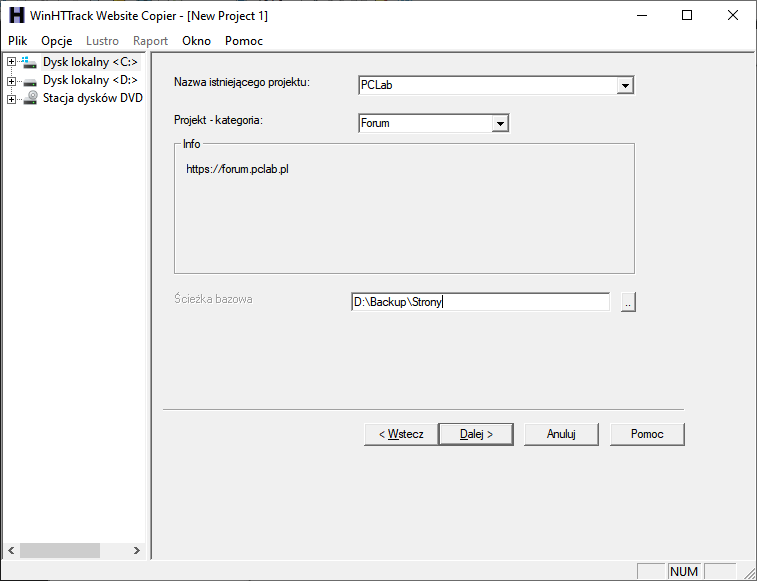

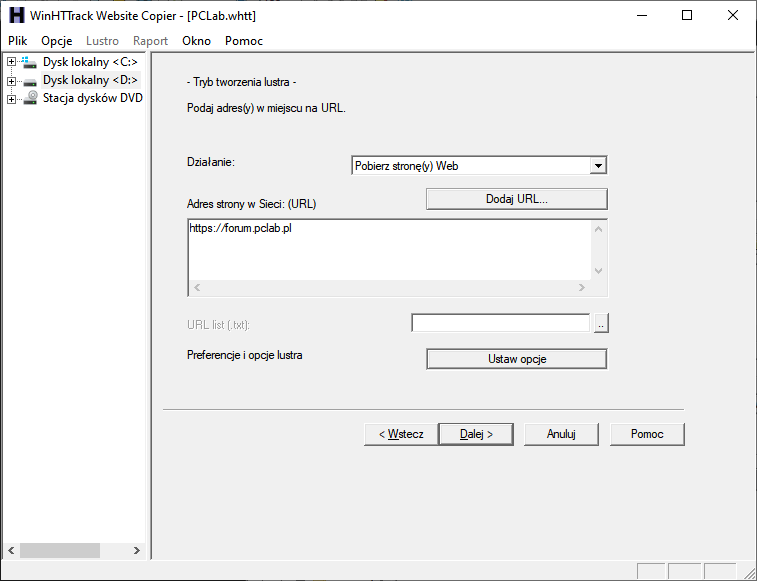

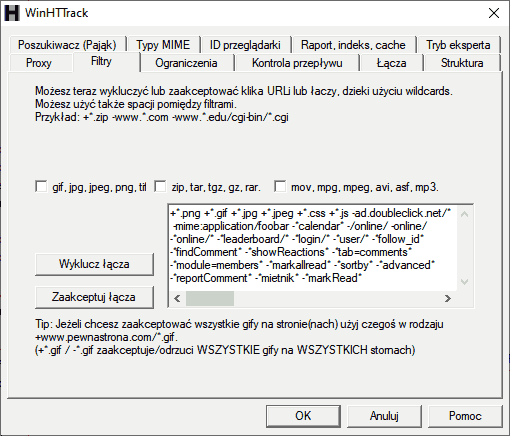

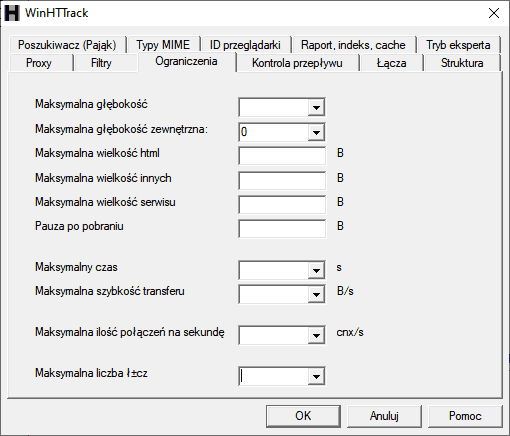

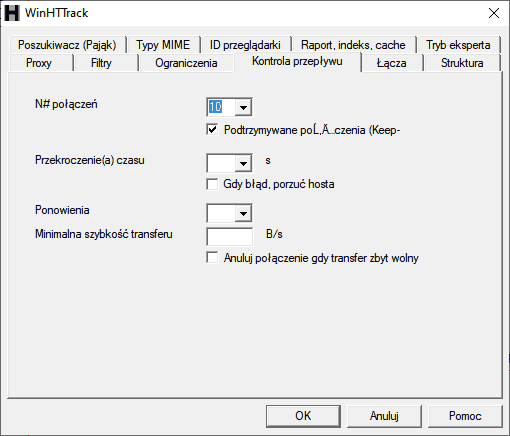

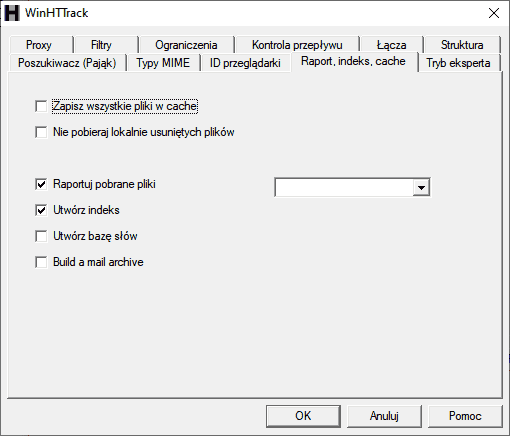

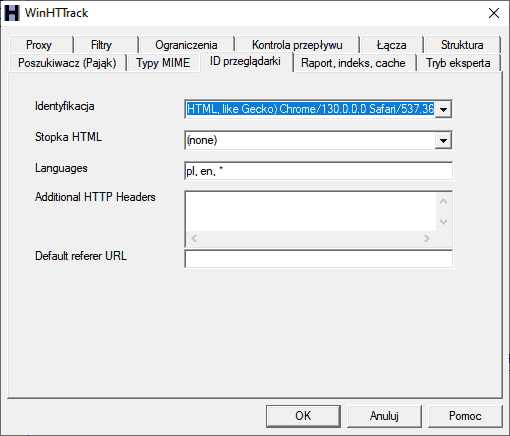

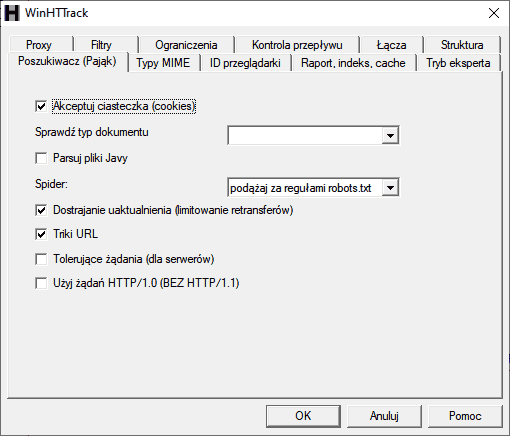

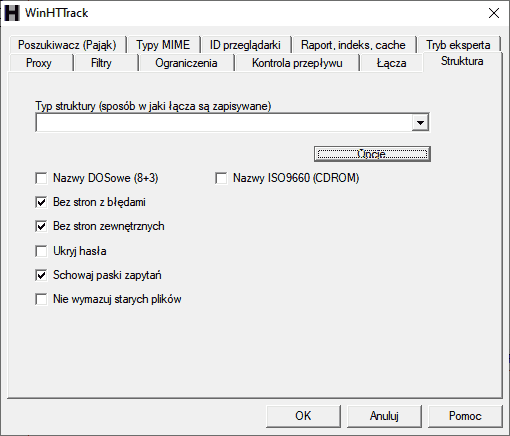

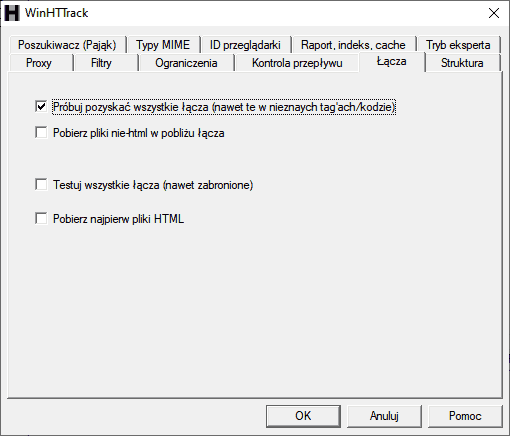

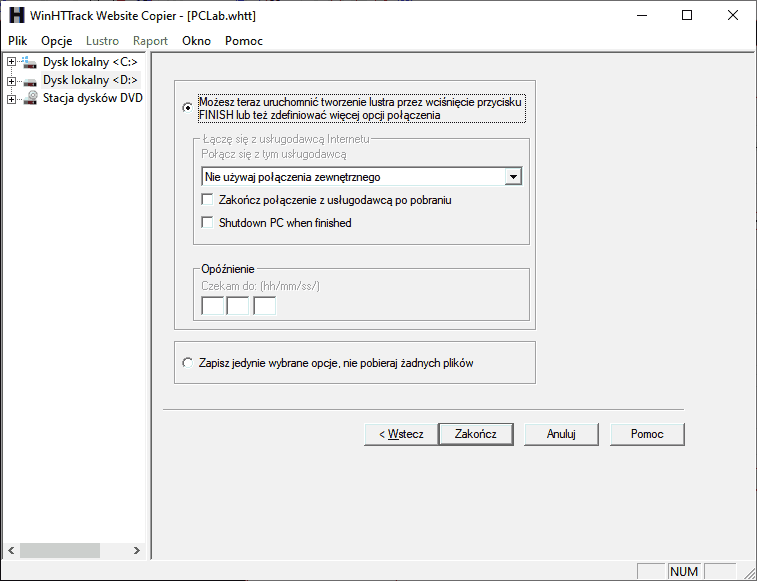

HTTrack jest o tyle fajny, że kopiuje witrynę dokładnie tak, jak wygląda i zapisuje także zewnętrzne obrazki. Można potem wygodnie przeglądać całe forum offline. Jak się przygotować: szybkie łącze dużo miejsca na dysku (2 TB lub więcej) lub: dysk zewnętrzny (zalecana opcja) domowy serwer NAS WinHTTrack Do programu jest dołączona instrukcja - po uruchomieniu wciskamy F1. Klikamy pierwszy link pod "How to use". Bardzo fajny jest też rozdział "How not to use", czyli czego nie robić. Wszystko jest po angielsku, a kto nie umie angielskiego, to niżej w tym wątku będzie opis po polsku. Po uruchomieniu programu klikamy Dalej i pojawia nam się ekran, w którym podajemy: nazwę projektu (jeśli zaczęliśmy już robić kopię, to wybieramy nasz projekt z listy) kategorię projektu - można wpisać cokolwiek (np. Forum) Klikamy Dalej i musimy wybrać sposób działania programu. Nas będą interesować dwie opcje: Pobierz stronę(y) Web - jeśli zaczynamy tworzyć lustro lub aby stworzyć je od nowa Wznów tworzenie lustra - jeśli przerwaliśmy tworzenie kopii i chcemy kontynuować Podajemy adres lub adresy URL, które chcemy skopiować, w tym przypadku forum PCLab. Klikamy "Ustaw opcje", bo trzeba dodać wyłączenia. Jak widać na zrzucie ekranu, w zakładce Filtry są wyjątki, gdzie robot ma się nie zapuszczać. Nie mam gotowej listy i być może takie latają po sieci dla każdego silnika forum. Trzeba ręcznie wejść na stronę i poszukać linków, których bot nie powinien klikać. Cel jest taki, aby nie ściągać wiele razy tych samych tematów lub zignorować niektóre podstrony. Nawet bez tych wyjątków HTTrack powinien poradzić sobie z forami na silniku Invision Community, ale na innych silnikach się zapętlał. Jeśli zaobserwujecie taką sytuację, że ciągle ściągane są te same podstrony, bo mają różne URL-e, to przerwijcie kopiowanie i dodajcie kolejne filtry. W kolejnej zakładce Ograniczenia możemy ograniczyć: głębokość - zostawiamy puste pole głębokość zewnętrzna - wpisujemy 0 pozostałe pola zostawiamy puste Forum nie miało ograniczenia ilość zapytań / IP, ale są strony, co używają WAF, np. Cloudflare i jak będziecie walić zbyt szybko, to wyświetli się captcha lub serwer zablokuje wasz IP. Może też wykryć zautomatyzowany ruch przez analizę zachowań. Wtedy warto ograniczyć częstotliwość. W zakładce Kontrola przepływu N# połączeń ustawiamy na 10 lub więcej, jeśli zależy nam na czasie. W zakładce Łącza zaznaczamy pierwszą opcję. Interesująca jest też ostatnia opcja. Nie zaleca się jej włączać, bo jeśli nie zdążymy wykonać kopii wszystkich plików HTML, to nie będziemy mieć żadnych obrazków, stylów, tak że strona się posypie po otwarciu offline. Pobierajmy wszystko od razu. W zakładce Struktura możemy pozostawić wszystkie opcje wyłączone. Opis: Bez stron z błędami - jeśli jakiś link prowadzi do nieistniejącej strony lub serwer zwróci kod błędu, np. 404 Not Found, to HTTrack nie stworzy dedykowanej strony z ostrzeżeniem Bez stron zewnętrznych - dla wszystkich linków zewnętrznych, które nie zostaną zarchiwizowane, HTTrack stworzy stronę z ostrzeżeniem, że należy przełączyć się w tryb online Schowaj paski zapytań - nie dołącza parametrów po pytajniku do nazw plików, bo starsze przeglądarki mają problem z otwieraniem takich plików - w przypadku PCLaba można włączyć (zaznaczyć ptaszka), bo Invision Community używa tzw. przyjaznych adresów (mod_rewrite) Nazwy ISO9660 - jeśli chcemy wypalić kopię na CD Nazwy DOS-owe - relikt przeszłości W zakładce Poszukiwacz (Pająk) zaznaczamy opcje jak na zrzucie ekranu: W zakładce ID przeglądarki warto ustawić innego user-agenta niż HTTrack. Wpisz w Google "jaki jest mój user agent" i skopiuj odpowiedź do pola "Identyfikacja". Opis opcji: Identyfikacja - jak robot się przedstawia (na zrzucie ekranu podszywamy się pod Chrome) Stopka HTML - wybieramy (none), nie chcemy wstawki "Mirrored by HTTrack" w każdym pliku Languages - zostawiamy pl, en, * Additional HTTP Headers - jeśli chcemy być zalogowani, to kopiujemy wybrane nagłówki z przeglądarki, szczególnie Cookie: (można to sprawdzić w narzędziach deweloperskich - F12 lub CTRL+SHIFT+I) Default Referrer URL - zazwyczaj nie ma potrzeby uzupełniania W zakładce Raport, indeks, cache ustawiamy wszystko jak na zrzucie ekranu. Utwórz indeks - tworzy index.html z listą pobranych witryn Utwórz bazę słów - tworzy index.txt z listą słów - tylko spowalnia pracę No i to wszystko. Klikamy OK, aby zapisać zmiany w ustawieniach. Ostatni etap to okienko jak poniżej. Kilka opcji, które mogą się niektórym przydać, w tym wyłączenie komputera po skończeniu wykonywania kopii. Klikamy Zakończ. Program rozpocznie pobieranie plików. Moment, chcesz właśnie odejść od komputera i wrócić za kilka dni? A jaką masz pewność, że wszystko dobrze ustawiłeś, że robot sobie radzi, a serwer nie blokuje możliwości wykonania kopii? Przez jakiś czas obserwuj, co się dzieje. Zwróć uwagę, czy: pająk nie zaplątuje się we własną sieć (odwiedza wielokrotnie te same strony) program nie buszuje tam, gdzie nie powinien (np. strony tylko dla zalogowanych) program nie blokuje się na czymś (np. na zewnętrznych obrazkach) Co jakiś czas obserwuj pracę programu. Otwórz kopię lokalnie i sprawdź: czy da się przechodzić między podstronami czy linki działają prawidłowo czy zewnętrzna zawartość jest osadzona Jeśli wszystko jest OK, to prawdopodobnie będziesz się cieszył kopią offline dokładnie tak jak wygląda. Szkoda, że ten poradnik nie powstał miesiąc wcześniej. Szukałem innych skryptów. HTTrack mógłby przez rok ściągać forum. Nie odpaliłem, bo kończyło się miejsce na dysku. Później zająłem się innymi tematami i totalnie zapomniałem o PCLabie. Zapuściłem dopiero dzień przed zamknięciem i HTTrack radził sobie całkiem dobrze. Inne skrypty pobierają samą treść i zapisują np. w formacie wątku na grupie dyskusyjnej. Natomiast HTTrack zapisuje witrynę w oryginale, ze wszystkimi stylami i obrazkami (nawet zewnętrznymi na innych hostingach) i potem można taką kopię przeglądać offline. Udało się przez noc zedrzeć 2 GB, niestety tylko pojedyncze strony wątków z pierwszych stron, a dużo było tematów do zachowania. Możecie bić. Próbuję dotrzeć do osób, co umiały się posługiwać tym szatańskim wynalazkiem i skopiowały większą część forum. Jeśli nie, to pozostaje nam to, co udało się w różny sposób pobrać + Internet Archive. Edit: Dużo osób stwierdziło, że całego forum nie da się skopiować, więc odpuściło temat, ale przez miesiąc dużo by się udało skopiować. Jeśli kiedyś nastąpi podobna sytuacja (chyba nie nastąpi, bo nie znam innego dużego forum z kilkunastoletnią historią z potężną dawką wiedzy), to trzeba się dogadać, żeby jeden użytkownik kupił duży dysk i wykonał kopię, a potem jakoś będziemy sobie to przekazywać pocztą pantoflową. Koszt dużego dysku zewnętrznego to 1000 zł, co obecnie dla wielu osób nie jest dużym wydatkiem, a przyda się do archiwizacji swoich danych. Udostępnić publicznie tego raczej nie możemy, niech się jakiś prawnik wypowie, więc można to zrobić na zasadzie, że po skompletowaniu tego, co udało się nam uratować, przekażemy sobie prywatnie kopie na własny użytek. Co jeszcze można zrobić, to podpytać ChatGPT, jak do pobranego HTTrackiem fragmentu forum dołączyć wszystko, co zachowało się w archive.org i innych miejscach. Teraz nie mam na to czasu, ale jak nikt nie da rady, to po nowym roku postaram się pomóc.- 54 odpowiedzi

-

- 1

-

-

- archiwizacja forum pclab.pl

- archiwizacja

-

(i 7 więcej)

Oznaczone tagami:

-

Migracja użytkowników z forum PCLab (*)

WebCM odpowiedział(a) na azgan temat w Dyskusje na tematy różne

Napisali "z dniem 29 listopada", a nie "do 29 listopada", więc wszystko się zgadza. Ktoś się łudził, że nie nastąpi to w godzinach pracy korpo? Adminowi musieliby zapłacić nadgodziny, aby w nocy wyłączył forum i ustawił przekierowanie. Co masz zrobić dziś, zrób od razu i nie zostawiaj koniec. W kwestii zarchiwizowania forum zawiodłem. Niestety wpadły mi inne tematy. Pytanie, które wątki forum PCLab warto zachować dla przyszłych pokoleń i które mają wartość historyczną. Korpo przynajmniej dało miesiąc na zapisanie swoich treści, natomiast znam wiele forów, gdzie administratorzy ukrywali całe działy lub z dnia na dzień forum przestawało istnieć, puszczając wkład społeczności i prywatny czas w niebyt. Szkoda jedynie historii polskiego Internetu. Ktoś kojarzy, czy oprócz archive.org są inne strony, co archiwizują treści? Wyszukiwarki odpadają, bo od dłuższego czasu nie wykonują kopii. Może to efekt zmian w przepisach, RODO, itd. Edit: Jak ktoś robił kopię całego forum, to priv. -

Migracja użytkowników z forum PCLab (*)

WebCM odpowiedział(a) na azgan temat w Dyskusje na tematy różne

Mam 2.57 GB zapisanych i 21 049 plików, niestety zachowały się tylko tematy z pierwszych stron działów i pojedyncze strony wątków. Gdyby od razu po ogłoszeniu zapuścić HTTracka, to większą część forum udałoby się zapisać. Może komuś się udało, dlatego pytam. Przestrzeń dyskowa jest tania, załóżmy 10 TB to koszt koło 800 zł, choć i tak tyle nie udałoby się zedrzeć w miesiąc. Nie czytałem całego wątku. Sam szukałem lepszych narzędzi i wygląda na to, że HTTrack to najlepsza opcja. Chcesz zachować część Internetu dokładnie taką, jak wyglądała, ze wszystkimi stylami, z dołączonymi obrazkami i wpisami z Twittera, itd. Nie znalazłem lepszego narzędzia do tego, a sam kopiowałem już kilka forów HTTrackiem, tylko trzeba wiedzieć, co poustawiać i dodać wyjątki, żeby robot się nie zapętlił i nie indeksował wiele razy tych samych podstron.