-

Postów

54 -

Dołączył

-

Ostatnia wizyta

Treść opublikowana przez Krisol

-

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Mam teraz Burst Assassina 120 EVO DARK na CPU z TL-C12B V2 i TL-C12RB V2 - Fluctus, Stratus i Arctic P12 są ciche i słychać głównie szum powietrza (oczywiście poza pewnym zakresem dla P12), natomiast te TL-C12B V2 i TL-C12RB V2 mają nieco świszczący dźwięk na wysokich obrotach. TL-C12C wyglądają podobnie do tego TL-C12B V2, więc podejrzewam, że charakterystyka dźwięku też będzie podobna. -

Up - nowa oferta

-

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Freezer 36 ma więcej finów oraz rurki direct-touch, Burst Assassin ma o dwie rurki więcej oraz miedzianą/niklowaną stopkę, myślę że ciekawe byłoby to porównanie. Assassin X to akurat jest pod każdym względem gorszy od Freezera 36, jedyna zaleta to cena ale to tylko 20 zł. -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Szkoda że nie wrzucił Burst Assassina Evo zamiast tego Assassina X, myślę że to najlepsze jednowieżowe chłodzenie do 200 zł. Potem za około 220 zł jest Cooler Master Hyper 612 APEX, no i top Noctua NH-U12A. -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

@Send1N A to nie jest tak, że 1050 RPM jest przy 12V, a splitter będzie podawał maksymalnie 6V na wentylator, czyli jakieś 525 RPM? -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Muszą być PWM, ponieważ mam tylko 2 wejścia na wentylatory przy 4 sztukach wentylatorów, przy 3-pin zgaduję że napięcie dzielone byłoby przez 2 przy y-splitterze. Czyli tych Thermalrightów nie warto nawet brać na testy? -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Przyszły te Stratusy ale też idą do zwrotu - jakość wykonania słabsza niż Arctic, do tego faktycznie nie są odczuwalnie cichsze od P12/P14. Warto coś jeszcze testować czy już zostać przy tych Arcticach? Thermalright TL-C12C lub TL-C14C ktoś miał? -

@JacekPlacek Miałeś wcześniej Intela? Takie temperatury to norma na Ryzenach, szczególnie na AM5 które mają gruby IHS.

-

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

@CryptTM Tylko że one się kręcą do 3300 RPM, komputer mi chyba odfrunie przy uruchomieniu. Ewentualnie zaryzykowałbym może Thermalright TL-C12C i TL-C14C, wydają się być mniej więcej na poziomie Stratusów. -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Chcę ogólnie wymienić a przy okazji wyeliminować to, co mi przeszkadza w obecnych. Stratus 120 ma 1400 RPM a 140 1200 RPM, gdzie Arctic P12 to 1800 RPM a P14 1700 RPM, różnica spora. P12 Pro i P14 Pro miałem ale poszły na zwrot, 3000 RPM i chrupnięcie przy starcie to dramat. -

Polecane wentylatory - testy, opinie, dyskusja.

Krisol odpowiedział(a) na temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Panowie potrzebuję jakieś wentyle PWM do obudowy Meshify C, priorytet cisza i niski max RPM. Stratusy dadzą radę czy dopłacić do Pure Wings 3? Teraz mam Arctic P12 i P14 ale już terkoczą/chrupią oraz irytuje mnie wchodzenie na 1800/1700 RPM przy każdy włączeniu komputera czy wyjściu ze stanu uśpienia. -

U mnie to nieco ponad 1.1V ale taktowanie rdzeni P lekko spada (gdzieś do okolic 5.2 GHz), każde 100 MHz więcej względem fabrycznych 5.3 GHz jest "drogie" jeśli chodzi o volty, a 130W to i tak jak dla mnie dużo jak na CPU.

-

Najprościej zmienić ustawienia jak poniżej: 1. Domyśle ustawienia BIOS/UEFI 2. Włączyć profil "Intel Default" 3. IA CEP -> off 4. CPU Load Line Calibration -> jak najniżej, najlepiej level 1 U mnie na PRIME B760M-A WIFI D4 daje to 131W i taki sam wynik w CB 2024 jak przy 181W (1382 punkty), chłodzenie Fera 3 daje radę.

-

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

Ostatni już test, Hogwarts Legacy, ustawienia ultra, RT ultra, frame gen on, DLAA, 1080p - ponownie bez różnicy w wydajności, gdyż alokacja VRAM przez grę na tym etapie to okolice 4.7GB. Podsumowując, można przyjąć, że w grach które potrzebują więcej niż ~7.5GB VRAM wydajność będzie wyższa jeśli monitor będzie podpięty do iGPU, jeśli potrzebują mniej, będzie taka sama lecz przy założeniu, że system to Windows 11, a procesor to Intel generacji 11 lub nowszy, bądź Ryzen 6000 lub nowszy. -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

Wiedźmin 3, ustawienia RT Ultra, DLSS quality, 1080p, frame gen - podobna sytuacja jak w Rift Apart, bez różnicy. -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

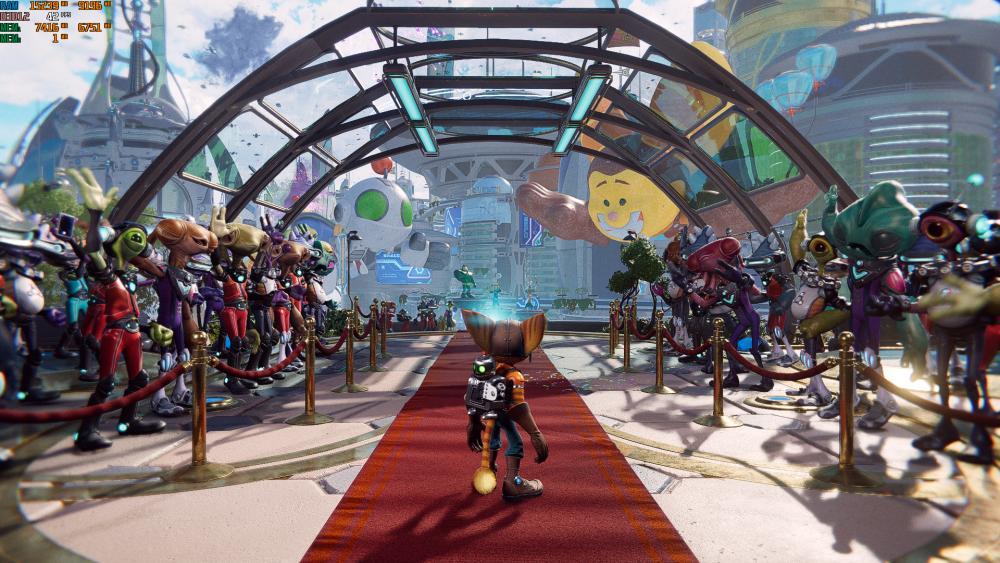

Rift Apart bez różnicy w wydajności, jednak to spodziewane gdyż gra na tym etapie wymaga jakieś 7GB VRAM, ustawienia very high + ray tracing very high, 1080p, DLAA. -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

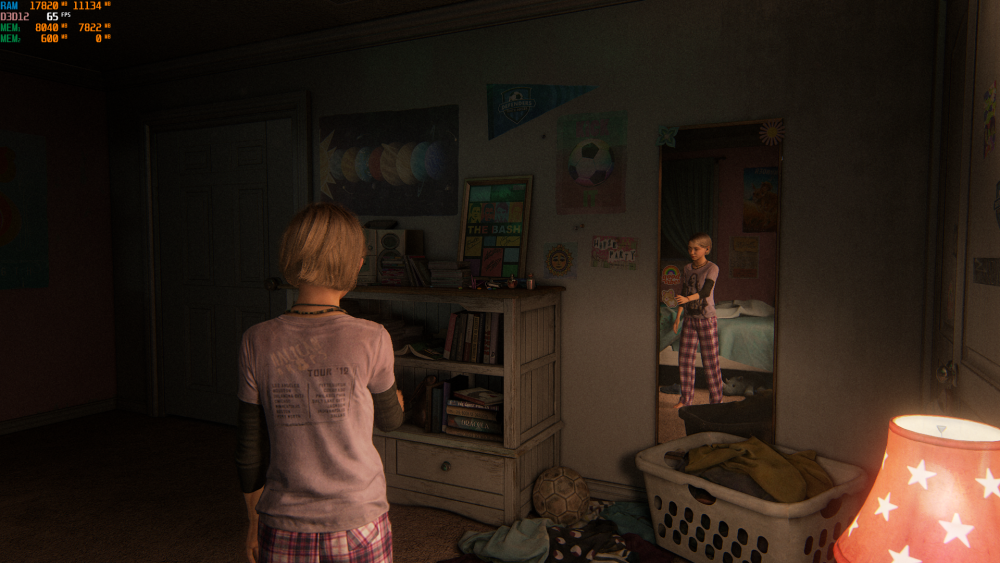

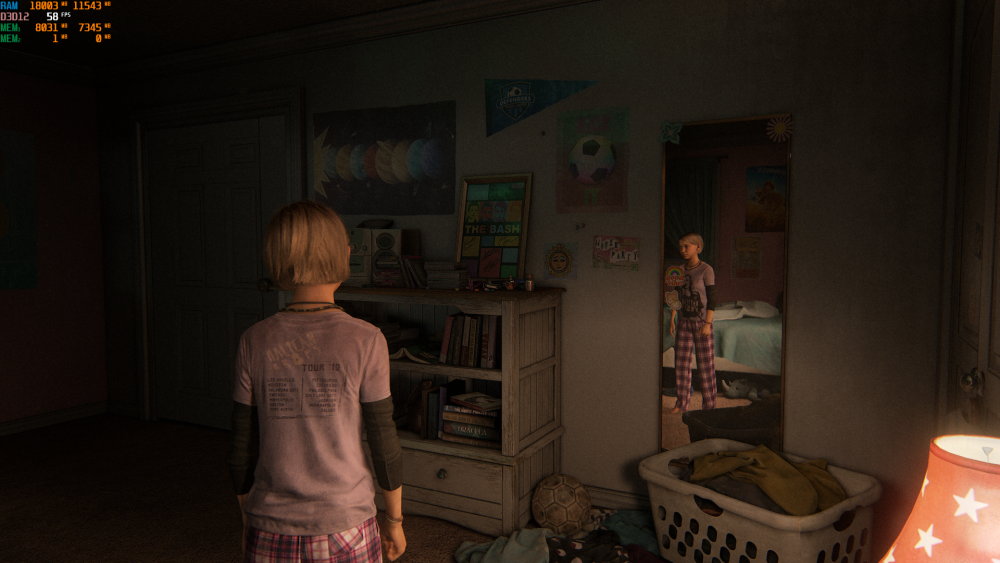

Nowy test i niespodzianka, w The Last of Us Part I wydajność jest o 12% wyższa kiedy monitor podpięty jest do iGPU. Najprawdopodobniej jest to zasługa dodatkowych 500MB wolnej pamięci VRAM na karcie graficznej. Poniżej zrzuty ekranu, wyniki powtarzalne - testy robione 3 razy, na zasadzie przepięcie kabla -> restart komputera -> uruchomienie gry. Ustawienia ultra, 1080p, DLAA. Zamierzam przetestować jeszcze parę gier, myślę że Hogwarts Legacy, Ratchet & Clank Rift Apart i może Wiedźmin 3. -

@VRman Tylko że 9800X3D + 5060 Ti 16 GB kosztuje tyle co 14600K + RTX 5070 + B760 z WiFi i PCI-E 5.0, który jest o wiele bardziej zbalansowanym zestawem, szczególnie do ewentualnego monitora 1440p.

-

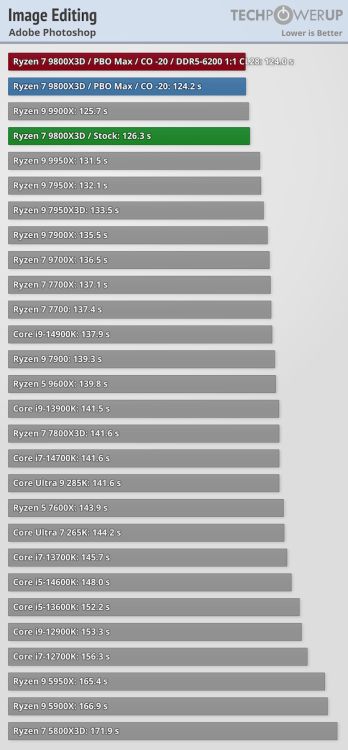

Tak szczerze to "najlepiej" kupić i5-14600K z DDR5 6800-7200, niedawno bywał za 599 zł w wersji KF, być może że jeszcze coś się pojawi - wydajność w grach na poziomie R5 9600X, w programach wielowątkowych jak R7 9700X. W porównaniu do 7800X3D - o 15% wolniejszy w grach, o 10% szybszy w programach, w porównaniu do 9800X3D - o 25% wolniejszy w grach, o 10 % wolniejszy w programach.

-

9800X3D będzie nieco szybszy w Photoshopie o ile to ma aż takie znaczenie, do gier lepiej RTX 5060 Ti.

-

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

Ci którzy posiadają starsze CPU mogą spróbować manualnie przydzielić procesy Windowsa do iGPU mając monitor podpięty pod dGPU. https://www.reddit.com/r/OptimizedGaming/comments/1j7jmvq/guide_reduce_vram_usage/ https://www.reddit.com/r/buildapc/comments/1mea3w0/how_to_decrease_vram_usage_with_an_igpu/ -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

Tak, CASO wymaga WDDM 3.0/3.1, więc zadziała tylko na W11 w grach z DX11 oraz DX12, dla Intela od premierowej wersji W11, dla AMD od 22H2. -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

No dobrze, moje prywatne testy mówią co innego niż ten prywatny test z YT. -

[TEST] Monitor podpięty do dGPU kontra iGPU

Krisol odpowiedział(a) na Krisol temat w Karty graficzne

Czyli bez obsługi Cross Adapter Scan-Out, spadek wydajności spodziewany. Tak jak pisałem wcześniej, brak spadku wydajności dotyczy tylko Intela gen 11+ albo Ryzena 6000+.