-

Postów

5 148 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

4

Treść opublikowana przez VRman

-

Ale to jest o 30% mniej dla AI, a nie 30% mniej pamięci w grze Weźmy na przykład taką sytuację. Gra zajmuje 10GB, obliczenia AI 1GB. To poprawę masz o 0,3GB a nie o 3GB

-

Ale oni teraz mówili sami, że chcą odbijać. Że to oczywiste, gdzie mają cały rynek discreet GPU to wiadomo. Zawsze jest nadzieja, że ktoś tą łajbę zawróci zanim kompletnie osiądzie na mieliźnie. Długoterminowo opłacałoby im się nawet pchanie kart ze stratami teraz, gdyby chcieli nie tyle nawet wygrać z NV co wrócić do np. zdrowego 35-40% udziału. Bo potem sprzedawaliby znacznie więcej kart w następnych latach. Do tego brakuje im: - dobrych kart w rasterze ale w sporo niższej cenie dopóki Nvidia ma taką przewagę w rozpoznawalności i.. no nie wiem jak to po naszemu, ale chodzi o "mind share". - conajmniej 2 albo i 3x lepszej wydajności w RT a przede wszystkim PT. Jak gry z PT specjalnie będą rzucać kłody pod nogi bo współpraca z NV, to AMD powinno zapłacić, żeby były też gry gdzie jest odwrotnie. Nie pochwalam moralności takich zagrywek, ale w tej sytuacji... A jeśli nikt niczego sztucznie nie blokuje, to powinno AMD sypnąć kasy, żeby PT miało sens także na Radkach - FSR przed 4 było sto lat za afroamerykanami w jakości DLSSu, szczególnie w ruchu to było jakieś nieporozumienie. Jest sporo ludzi, którzy tylko przez różnice w DLSS vs FSR wolą dopłacić te 15% do NV. Teraz jest szansa, że FSR będzie w końcu porównywalne z DLSS. Framegen nie będzie tak pożądaną funkcją jak DLSS od wersji 2. Nvidia wali chore ceny. Tu naprawdę moim zdaniem jest pole do manewru i zawalczenie. Tylko czego się spodziewać po firmie, której marketing słynie co jakiś czas nie z prezentacji, tylko z tego jak się cały internet z nich śmieje albo na nich wkurza. Ostatnio wtopa z Zenami 9xxx gdzie poprawy nie ma prawie żadnej, a naściemniali. Wcześniej przed premierą 5800x3d ich dział makretingu nie rozumiał nawet potrzeb graczy i zamiast skupić się na +50% w 1% lows i pokazać gry z +40% w AVG, to pokazał słupki średnie i chyba +15% czy ile tam. Żeby przeceniać swój produkt to norma, ale żeby go pokazać jako dwa razy gorszy niż jest faktycznie, to potrafi chyba tylko i wyłącznie dział marketingu AMD. A teraz ten CES i zrobienie z siebie pośmiewiska z premierą/niepremierą RDNA 4. Szkoda, bo jakby chcieli to by mogli. Tak samo jak Ryzeny przez 5 lat nie interesowały nikogo, kto chciał do kompa najszysze CPU albo może max 10-15% wolniejsze i w tej grupie graczy AMD miało zerową sprzedaż. I też pewnie ktoś tam u nich mówił, że to pozycja Intela, że się nie da. A wyszło 5800x3d i potem 7800x3d i patrz pan, cud. Niemal w mgnieniu oka z 0% na 90%. Oczywiście gracze wymagający naj-naj-najszybszego proca w grach to malutka nisza, ale chciałem pokazać mechanizm "porażek na własną prośbę". Coś mi mówi, że tam jacyś debile anulowali zajebiste karty przed premierą serii 7xxx. Mówili sami i były plotki o modelach z dodatkowym cache. Jak ich znam to pewnie bali się, że ludzie będą w 1080p testować i karty źle wypadną, a poza tym nikt przecież karty za np. 1400$+VAT nie kupi. (A potem wyszło 4090 i schodziło jak ciepłe bułeczki. No z tym to racja.

-

Mój komentarz do cen. Nic więcej w tym poście nie ma. No, i niestety. 600+VAT za 9070xt to tak samo jak 999$. W obu przypadkach karta guzik zrobi a nie zawalczy o porządne odzyskanie części rynku. To jest 3080zł. Sorry, ale bądźmy realistami. W tej cenie to 90% ludzi wybierze 4070Super albo dołoży trochę do 4070Ti Super. Może AMD już wlicza pogorszenie perf/$ po wycofaniu 40tek i zastąpieniu 50tkami. +5% wydajności a +20% do ceny takiej 4070Ti Super to może coś AMD sprzeda, ale mimo rozumienia powodów, przez które to nierealne finansowo przy obecnym wolumenie Radków, ta karta powinna kosztować o 1/4 mniej. Nawet jeśli FSR4 jest super i nawet jeśli w RT ta karta prześciga odrobinę 7900xtx. 9070 za 2570 +Januszowe. Nawet w MSRP to każdy wybierze dodanie 300zł i kupno 4070Super. więc albo nie obniżą i seria będzie kontynuacją zaniku udziałów AMD w rynku gamingowych GPU, albo znowu obniżka po premierze i cały potencjał marketingowy w kibel

-

@PepePanDziobak A proszę bardzo. Oto wszystko w tych 66 stronach warte uwagi: - Nie ma za co. A co do Jay2centa to dokładnie jeden z tych idiotów, co potrafią chwalić cenę 4090 bo przecież obniżyli względem 3090ti więc zajebiście A daj pan spokój z pajacami z jutiuba. Chwyci się czegoś - tego jednego co wypadnie dobrze - nie wiem, kodowania video, displayportu, ilości RAMu czy wyniku w jakimś programie i będzie "paczta, jest trochę drożej, ale lepiej, a do tego frejmgen i nie słuchajcie marudów, karta super! edit: no i oczywiście będzie zakładał MSRP przy chwaleniu, a nie 130% MSRP w sklepach.

-

Właśnie sobie uświadomiłem czytając posta wyżej, że to jest idealne zastosowanie AI. Zrobić support agenta z indyjskim akcentem i absolutnie NIKT ani nie będzie miał pretensji, że AI się tu czy tam myli albo gada bzdury, ani nie połapie, że to AI. Aż dziwne, że z takimi pomysłami nie jestem jeszcze miliarderem.

-

To był sarkazm. Dalej byłoby to jasne, ale ja też w tym wątku często czytam pierwsze kilka wyrazów i scroll dalej.

-

OLEDy 480 czy 1000Hz to tylko marketingowy bełkot. Nic kompletnie nie wnoszą i są tylko dla dzieciarni i e-sportowców. Przecież jak komuś kazać policzyć klatki na monitorach 50Hz i 60Hz to by nie dał radę policzyć. Już monitory 120Hz to był pic na wodę i chwyt marketingowy dla idiotów. Każdemu mądremu dojrzałemu graczowi wystarcza 60Hz, a nawet 30Hz, ale do 30Hz są źle napisane sterowniki do myszki i w 30Hz kursor trochę pływa. To nie zarzucaj takich baitów Jak jakimś cudem to nie bait i na serio tak bardzo nie rozumiesz tematu, to masz w necie łatwy dostęp do artykułów. Za darmo i nie trzeba nawet dużo czasu. Wystaczy 5 minut i zrozumiesz czemu Twój wpis o "360 za mao" jest śmieszny tak samo jak konsolowcy 15 lat temu piszący dokładnie to samo o 120Hz - że bez sensu, ze dla snobów, że dla cyborgów, esportowców i każdemu dojrzałemu graczowi starczy 60Hz. Różnice co prawda dotyczą innych aspektów grania, ale poziom ignorancji tak samo wysoki. @Kadajo Nie chce mi się oglądać paplania o DLSSie, ale żartowałeś, czy on na serio wspomniał o monitorach 1000Hz? Kurde, czyli Mark R. z Blurbusters nie przesadzał jak pisał, że ma wrażenie, że Nvidia w końcu zaczyna rozumieć ważność dobrej jakości obrazu w ruchu. Jeśli oni na serio zrobią FG pod 1000Hz, to znaczy, że będą celowali w nie tyle obraz dobry w szybkim ruchu, co wręcz w żyletę. Bardzo dobry sygnał, jeśli gość z NV w ogóle rozumie, że 1000Hz jest warte gonienia. Wręcz świetna wiadomość, serio

-

Zacznę od wyjaśnienia, że to jest najgorszy czarny scenariusz. Nie to, co piszę, że będzie, bo gdzieś wyczytałem, ani nawet nie to co twierdzę, że będzie. Wyszłyby dwa długie posty pod rząd nie bardzo na temat. To może tak:

-

A zgadnij... Oczywiście, że to drugie. To, plus może jakieś info o konstrukcji kart, chłodzeń itp. No i kolejne bardzo źle wróżące bardzo wysokie ceny w sklepach w Europie.

-

OK. Po wstępnej analizie naprężeń cenowych i wykonaniu badań powierzchni marketingowej, oceniam, że będą albo nie będą.

-

To po części prawda, ale proc lepszy o tylko np. 30-40% nie wystarczy na żadną nową "generację". Jakby dali cache i skoczyłoby o +100%, to by można puścić grę w 60fps z detalami ala gry z PS5, które chodziły w 30. Oczywiście to nie do końca prawda, bo liczy się też GPU itp. ale wiesz o co mi chodzi. Przy małym skoku ludzie będą marudzić, a to mocno będzie skłaniać developerów a raczej wydawców, żeby cisnęli lepszą grafę kosztem framerate'u. Na PS4 marudzili w PSX Extreme w recenzji, że gra MGS V chodzi w 60fps i fajnie, ale nie wygląda nextgenowo Na PS5 marudzili, że nie czują skoku, bo gry chodzą w 2x większej liczbie klatek i wyższej rozdziałce i to w zasadzie tyle. To głupota, która odbije się Sony czkawką, jeśli nie dadzą proca o 100% szybszego. A skoro projektowali go tak wcześnie, to pewnie nie dadzą. Szczególnie, że taki proc w grach ciągnąłby ze 70-120 Watt, do tego kolejne 20W na podbiciu napięć na systemie pamięci (bo względem Ryzena 3600 (coś ala CPU w PS5) wyraźnie przekracza granicę 200% dopiero 9800x3d, ale liczmy nawet te 7800x3d w np. wersji na 6 jaj) a przecież musi zostać na GPU i te wszystkie EJ AJe. Jeszcze się połudzę, że dadzą coś sensownego typu 6-jajowy 7600x3d + kilka rdzeni typu energooszczędnego, ale jeśli tak mocno już pompują hype na AI, to pewnie cała para znowu pójdzie w GPU i popełnią dokładnie ten sam błąd co przy PS4 (o wiele, wiele za słaby proc)

-

Ale dlaczego tak wygodnie sobie uogólniasz? Najpierw ta zdarta płyta "mi nie przeszkadza, a jak innym to widać grają z lupą", czyli takie same mądrości jak komentarze konsolowców typu "mi te 24 czy 30fps wystarcza, ale ja gram, a nie liczę klatki jak niektórzy" czy "na co mi PC i lepsze tekstury? Gram na PS3 i się świetnie bawię, nie potrzebuję lepszych tekstur, jak ci co grają tylko po to, żeby szukać kamienia, a jak znajdą to wrzucają na fora onanistów pecetowych, żeby pokazać że tekstura jest rozmyta". Dalej kolejne uogólnienie, że piszą ci co mniej grają. A masz kamerkę szpiegującą u każdego forumowicza, że wiesz? Nie widzisz wad, które by Ci przeszkadzały, to spoko, ale jak Kadajo wyraża swoją przeciwną opinię to ma też do niej prawo. A jechanie po Nvidii nie wynika z tego, że ludzie lubią jechać po Nvidii, tylko dlatego, że Nvidia robi z graczami i branżą co robi. Mamy bić brawo, bo na karcie za 14000 jest lepiej niż na konsoli za 999zł czy jak?

-

Czyli dokładnie to, czego się można było obawiać. AMD nie nauczyło się kompletnie NIC i po raz kolejny chciało sobie przywalić w stopę na premierę, przyklejając Nvidiowe ceny do swoich Radków, ale nie mając skórzanej kurtki. Dobre tyle, że się ogarnęli i rozumieją już, że kolejny raz "damy -10% do cen analogicznej karty od NV" nie przejdzie. Cały zarząd marketingowo-finansowy, który decyduje o stragetii cenowej Radeonów w ostatnich latach powinien być wywalony z roboty z efektem natychmiastowym. Ja rozumiem, że sprawa nie jest łatwa, że nie można od początku powiedzieć partnerom o niższej cenie, bo NV to skontruje itp. No ale ja pierdzielę, to jest jakaś totalna amatorka i debilizm.

-

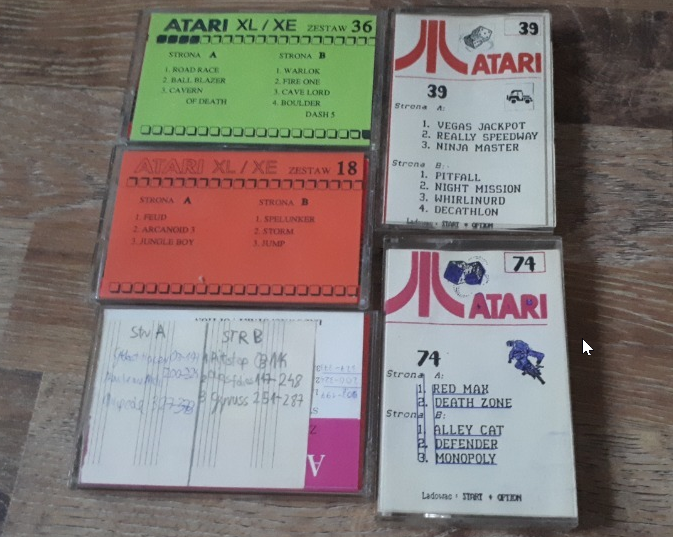

ee tam. (to niżej to nie moje zdjęcie, bo sprzedałem wszystkie kasey razem z Atarynką) Ala ja nie o tym. Chciałem zapytać czy jest tu jakiś wątek bardziej pasujący do dyskusji i zrzutów ekranu/filmików na temat emulatorów obrazu CRT? Ja już sobie na YT co kilka dni szukam czy ktoś coś wrzucił. Potem na swoim starym LCD odpalam wyższą jasność, siadam na kanapie daleko od monitora i podziwiam grafę robioną przez prawdziwych artystów w latach 80 i 90tych. I chciałbym zapytać czy nie da się takiego filtra czasem nałożyć na video. Chciałbym też zobaczyć jak wygląda np. gra z Amigi na monitorze 1080p vs 4K, bo tylko 1080p mam w domu, a te symulacje kineskopów ponoć wymagają 1440p a najlepiej 4K, żeby wyglądać bardzo dobrze. Nie tylko Ty Ale ja nie znam. Znałem. Pamięć ulotna niestety. Rozpoznałem, ale to tyle.

-

Właśnie o to chodzi. Że co by nie było, to w perf/$ będzie regres (godny soczystych memów, na które się już nie mogę doczekać . Celowałem w 5070ti w przyszłości, więc to nie tak, że mnie to cieszy, ale co nam zostało? Płakać? Przynajmniej się człowiek pośmieje, zdrowszy będzie) Te karty zaczną mieć jakikolwiek sens dopiero z kostkami 3GB, ale wtedy cena może znowu polecieć do góry, choć nawet bez tego byłoby za drogo.

-

4070Ti super vs. 5070Ti, więcej jednostek dla rastera i.. niższy zegar. A przeliczmy to razem. Dokładnie 99,9% wydajności teoretycznej tych jednostek w 4070Ti Super osiąga 5070Ti. (Nie, nie odwrotnie) Jak jakaś gra miałaby mieć zerowe skalowanie z przepustowością pamięci (co chyba jest nierealne) to dopiero będzie śmiesznie

-

https://wccftech.com/playstation-6-soc-design-complete/ Jak ktoś chce po polsku to sorry, musicie użyć tłumacza, bo linkować do szamba zwanego ppe nie będę. W skrócie: zakończono projekt SoCa do PS6. Eh, niedobrze. To sugeruje, że nie zamierzają robić prawdziwej premiery a jeszcze bardziej papierową niż przy PS5, czyli konsolę teraz, a exy na nią po 4 latach, a przez ten czas cross-geny. To jedyne sensowne wytłumaczeni powrotu do cyklu życia jak dawniej, bo ostatnio wyniosił on 7-8 lat (x360/ps3 2005, ps4/Xone 2013, PS5/XsX 2020) Jeśli i tak lecą pół dekady na crossgenach to im premiera nowej konsoli nie zaszkodzi w niczym. Druga sprawa, że to za szybko. Tępi krawaciarze mogli nie zdążyć zauważyć, że CPU z dodatkowym cache to jedyna słuszna droga. Bardzo się obawiam czy nie dadzą proca bez dodatkowego cache'u. Jak nie dadzą, to 90% gier będzie chodzić znowu w 30fps w grach na Unreal Engine 5 i i 6 i w grach z ray-tracingiem. Obawiam się też, że TSMC nie zdąży z procesem 2nm (GAA) na czas, żeby Sony z niego skorzystało. Czyli co? PS5pro okazała się PS5.1 a nie pro, a prawdziwe PS5pro dostaniemy pod nazwą PS6, ale z większą ilością RAMu i ej aj ej aj ej aj ajajajaj?

-

@Pentium D https://en.wikipedia.org/wiki/Blackwell_(microarchitecture) 10 miesięcy po premierze wersji profesjonalnej, 11 licząc dostępność w sklepach. Czyli początek 2026 + 10-20 miesięcy @areczek1987 Indiana Jones z PT już ma problemy mimo tego, że dev przyznał w wywiadzie, że to nie błąd, że w grze brakuje sporej części RT. Np. na wodzie nie masz odbić. Póki co (ogólnie, nie w Idnianie) te RT/PT wygląda jakby było na medium, a nie na ultra. Tu nie ma cieni, tam nie ma odbić, a tam jest pop-in bo zasięg obejmujący RT/PT jest mały i za blisko kamery widać granicę. Jak kiedyś zrobią patcha do Indiany, to na pełnych detalach 4080tce na pewno zabraknie, a zresztą nawet w tym wątku ktoś pisał, że bawił się tym PT i na 4080 miał problemy. A po premierze za (być może) pół roku wersji 5070ti i/lub 5080 24GB raczej wymagania nowych gier z PT w dół nie polecą. Chyba widziałem w testach gdzieś na YT jak ktoś miał 18GB w 4K wykorzystane. Te gadanie Nvidii o kompresji i obniżeniu zużycia pamięci w 5xxx, to jest podobne do tego co słyszę na każdym pokazie mody kurtek skórzanych od czasów Maxwella, a 4060tki 8GB nawet z FG nie mogą korzystać bo mimo kompresji i tak im brakuje, więc jestem sceptyczny jak to słyszę. Ogólnie 16GB dziś starcza. Na styk. Ale kto kupuje kartę za 6-7 kafli nie oczekując, że choć ze dwa lata pociągnie wszystko na max? Dlatego popularność 5080 nie spowoduje obniżek 5090 3 miesiące po premierze tym razem IMHO.

-

Ale wtedy były inne okoliczności: - mniejszy chip (dostępność) - obecność tańszej karty, która była szybsza niż poprzednia generacja (4080 vs 3090t)i i miała sobie radzić z RT/PT, więc ludzie widzieli Cyberpunka i myśleli, że na 4080 też będzie ok. Teraz jest tak, że jak chesz PT to masz albo 4090 albo 5090, przy czym 4090 zaraz pewnie zniknie ze sklepów. Wtedy 4090 pokupowali już ci najbogatsi i napaleni, a reszta brała pod uwagę 4080. Teraz jak ktoś chce wypas kartę "future proof" to nie ma wyboru. 5080 w PT będzie już kuśtykać, a w nogi jej się zapląta 16GB. Upadnie i sobie ten głupi ryj rozwali na plus: ta plotka o przestawienie linii z GPU pociągowych na GPU growe, bo pociągowe im nie wyszly.

-

Taa, a te 32GB to jest tylko przypadkiem. Wcale nie jest tak, że poza 20GB nie wychodzi w zasadzie nic i do grania starczyłoby nadal 24 i to tylko przypadkiem przez 32GB graczom zgarniać będą karty ludzie kupujący kartę do pracy lub AI. No i jakby zostało 384bit to by się nie dało nawet tych 22-35% podbić bez podpierania się AI, a tak to yutuberzy dostaną wytyczne, żeby mówić, że "no co no, dobrze jest, tylko te inne segmenty złe, ale patrz na 5090, jest nowa generacja!" Poza tym to jest ogromny układ, którego uzysk kosztuje sporo, a chipy bez defektów mogą być sprzedane za sporo więcej (albo nie do gier, albo zrobią modele 64GB albo po prostu będą odkładać na półkę i potem domalują "Ti". Nie byłbym pewien tych obniżek w późniejszym okresie. @Pentium D Zapomnij. Nawet nie wiadomo czy, a skoro taki "refresh" dostaliśmy po 2.5r. i AMD nie stanowi konkurencji.. Od momentu premiery nowej architektruy do obliczeń nigdy nie minęło tylko pół roku do wydania wersji do gier. Końcówka 2026 najszybciej, a pewnie później lub wcale.

-

Po co ma stawiać na raster? Serio pytasz? Tobie tej wydajności wystarcza. Innym nie. Kliknij w spojler jeśli chcesz przeczytać czemu się absolutnie z tym co napisałeś nie zgadzam i dlaczego.

-

E, są gorsi (odnośnie spamu). Ja nawet w pierwszej 10tce nie jestem Tak, rozumiem o co Ci chodzi. Ale to nadal będzie dla bardzo wielu za mało, żeby to uznać za używalne. W tym sensie. Przecież w grach z PT to się 4080tka ociera o zawał serca.

-

Też tak sądzę. Mogą na czekaniu tylko zyskać. A że wychodzą na idiotów i przypominają skulonego pod stołem pieska drążcego ze strachu przed Nvidią to inna sprawa. Nvidia lubi zaskakiwać cenami na samym końcu, więc mają pierwszy powód. Nieogarnięcie sterów i FSRu to całkiem prawdopodobny drugi powód. Jakby na CES mieli to ogarnięte to nazwaliby to FSR FSRerm. A nie nazwali. Jeśli faktycznie nadal w ciężkim RT będzie tylko trochę lepiej, gdy AMD brakuje nie trochę, a 2-4x, to czym mają reklamować te karty, jeśli to nie odstawi istotnie 7900gtx w grach z ciężkim RT/PT? Tylko FSRem, więc jeśli zawalą pierwsze wrażenie i nie będzie zachwytów u recenzentów, to kaplica. Co do rasteru, to jeden słupek nigdy nie powie prawdy. Ważna jeszcze jest charakterystyka różnic i są zmiany między DX12 a starszymi. Osobiście wolałbym kartę z wydajnością średnio np. 10% gorszą, ale za to bez ryzyka, że nadzieję się na grę, która ma stutter bo spadki są o 35% gorsze od tej karty, która niby średnio jest nawet trochę szybsza. A tu.. znowu wiele zależy od sterowników. Może nie ogarnęli, jeśli 99,9999999999999999% zasobów (programistów) popchnęli do AI bo kto by się tam GPU do gier przejmował. Bardzo wątpię w tą brzmiącą wyjątkowo durnie wymówkę o tym, że to specjalnie, bo niby RDNA jest takie super, że aż zasługuje na osobną konfę.

-

To było półżartem, a chodziło w nim o to, że niższy proces G92 vs 92b to większa poprawa wydajności (nie zmian jako takich w chipie) niż teraz w przejściu na serię 5xxx, bo niższy proces dał o 8,76% wyższy zegar i podobną różnicę w testach przy tym samym TDP (według TPU przynajmniej)

-

O, coś nowego. Youtuber, któremu się wydaje, że wie co mówi.