-

Postów

5 747 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

4

Treść opublikowana przez VRman

-

Można klikać w ignorowane posty i je rozwijać. A ja nie zamierzam pozwolić ruskiej trolowni naganiać wyborców proruskim partiom. Choćby i te forum oglądało średnie półtora wyborcy na rok. Po prostu nie powinno się pozwalać. Podsumuję: - Volt tak sra ruską propagandą, że Kadajo mu kazał przystopować - ja wiele razy dawałem mu szansę wytłumaczenia, co powodowało jego skrajnie anty-ukraińskie i mocno pro-ruskie wypowiedzi. Volt to wesoło ignorował. Po tym przestałem dawać mu tzw. "benefit of the doubt". - inni userzy, jak widać wyżej, też mają dosyć. On nie pisze w wątku o wojnie. Mu się wydaje żet to wątek o tytule "anty-ukraińskie newsy zebrane z ruskich telegramów i od Zaharovej". I jako mod, masz prawo mu przywalić za choćby właśnie to sranie offtopem. Już nawet pomijając to, że ZAWSZE ten offtop jest waleniem w Ukraińców mającym na celu to, żeby Polak znienawidził Ukraińców. Jak będziesz miał w Polsce za dekadę rząd tworzony przez ruskie pacynki, to sobie przypomnisz czemu do tego doszło. A potem że to przez ruską agitkę, na którą Polacy pozwalali. A potem przypomnisz sobie ten wątek. Nie będziesz wtedy na siebie w...ny? Bo ja bym był. Dlatego apeluję o usunięcie tego trola z tego wątka.

-

Haptyka? Używasz dodatkowych akcesorii do haptyki? Widzę support dla tego w zaskakująco wielu grach na Questa standalone. Chyba nie chodzi o same wibracje w kontolerach?

-

9 ruskich majorów, 1 pułkownik poszło do piachu. Mars Ja ignoruję, ale on robi tu pro-ruską agitkę. Sra offtopem i nonstop wali w ukraińców. Teraz nazwał ich faszystami. Nie mieści mi się we łbie, że mu na to pozwalacie. Z miesiąc temu Kadajo tutaj pisał, żeby z tą onucową agitką przyhamować, nie podziałało, więc teraz czas na kopa w dupę. Najwyższy.

-

Napisałem, że mam z takim sterowaniem na koncie grube kilkadziesiąt godzin (może i ponad sto, nie liczyłem) (choć nie w tej konkretnej grze ani nie na trackingu na Lighthouse'ach, który zakładam jest istotnie lepszy) i obok tutaj w wątku masz dwóch userów, którzy Ci też piszą, że to jakoś działa, ale nie ma to jak fizyczny sprzęt. Nie zgodzimy się raczej, bo chyba zupełnie czego innego oczekujemy od latania w VR i inaczej też latamy. Ja leję na realizm. Mi się gęba cieszy jak robię łuk dookoła wieżowca, jak lecę do góry nogami i patrzę na fizyczny sufit (albo i dalej) szukając przeciwnika w pojedynku ala te z IIWŚ, albo jak przelatuję przez bardzo wąski tunel bez rozbijania się. Fajnie też mi się lata akrobacyjnie, no i sorry, ale przynajmiej jeśli chodzi o sterowanie w Questach, to to obok fizycznego joya nie stoi. Nie ma co się przekonywać, bo każdy gra tak jak lubi, w co lubi, i na czym lubi. Tyle, że przez pogranie na trackingu pozycji kontrolerów od Questa, teraz się zastanawiam czy da się zrobić do gier na PC VR taki kij jak w starych samolotach, nie joystick, a kij, który sie tak mocno przesuwa na boki, jak żaden joystick do gier. Nie patrzyłem nigdy na to, co jest dostępne w wyższych cenach. Ciekawe czy takie sprzęty są dostępne. No fajnie się tym macha. Wkręta w dwupłatowcach jest zajebista i aż się gęba cieszy. Ma to swój urok. Tylko, żeby to fizycznie był kijek/drążek, a nie nicość. Podobnie z minigolfem - fizyczne trzymanie kija to spory plus. Podobnie z wyścigami. Gram na kierownicach od 1998r. i może i przeszedłem dwie gry na Questa w VR kierując nieistniejącą kierownicą (trzymanie rąk w powietrzu, gdy gra śledzi nieudolnie pozycję kontrolerów) ale do kierownicy to się nie umywa. I to samo do pewnego stopnia z lataniem. Fizycznie to fizycznie. Nawet jeśli odjąć responsywność i precyzję, to jednak po prostu fajniej jak masz w łapie coś prawdziwego.

-

Zapytaj czy ma w planach wpisanie tutaj choć jednego posta na miesiąc, który nie jest w 99% zgodny z postami ruskich troli. Przecież on co chwila tu wchodzi srać antyukraińskimi "newsami", doniesieniami itd. Właśnie nazwał Ukraiński rząd "faszystowskim". @Kadajo @Mar_s no błagam. Ile jeszcze będziecie to tolerować?

-

@some1 O, ktoś się niechcący wypaplał. 5080 24GB na 99,99% się pojawią, ale czy za miesiąc czy za 8 miesięcy to już ciężko powiedzieć. To było wiadome od końca 2024. Tyle że dziś nie robię sobie już nadziei na to, że wersje 24GB zepchną wersje w 16GB w pobliże dobrych bardziej normalnych cen. Brak karty 384bit wydaje się tu być celowym zabiegiem, żeby pożyteczni idioci i przekupieni jutuberze gadali, że "może cena jest sporo wyższa, ale pomiędzy 5080 a 5090 była ogromna przepaść, a teraz coś jest, więc dobre i to". Jeszcze w styczniu myślałem, że 24GB będzie na koniec roku tym co 4080S dla 4080. Że po prostu 16GB zląduje w okolice 4100-4500, gdzie jej miejsce, a wersja 24GB zajmie miejsce w przedziale 5000-6000. Teraz to do 5000 5070ti dochodzą, a GDDR7 3GB nie są jeszcze tak masowo produkowane, żeby nie były sporo droższe. Stąd wniosek, że im szybsza premiera, tym większa szansa na kolejne windowanie cen. Założmy, że Nvidię zmiana kostek na 3GB kosztuje dodatkowe 100$. (nie sądzę, raczej sporo mniej), to można założyć +400$. Czyli jakieś 8000, jak znam tych dusigroszów w Nvidii

-

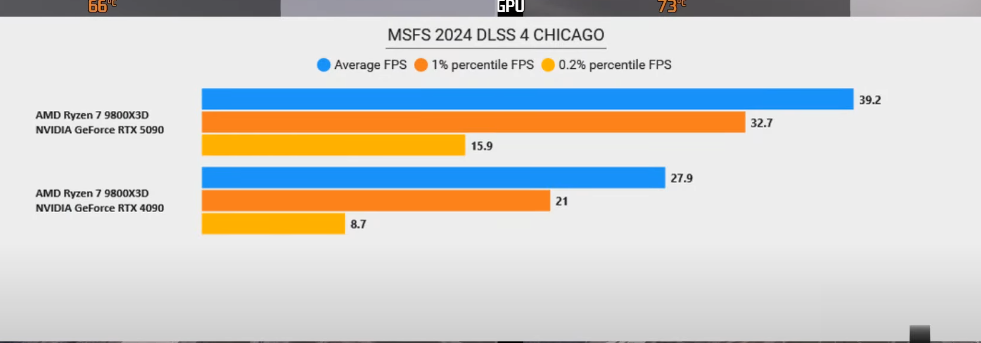

Z jednej strony pełna racja, ale z drugiej strony do headsetów o najwyższej rozdzielczości, brakuje mocy nawet 5090tce. Do tego gry tego typu wiszą na CPU i to nawet tak mocno, że 9800x3d ma problem z 40fps. I wtedy jak zjedziesz z ustawieniami do tych bardziej sensownych 45fps, to realnie karta o 500% szybsza może pokazać wzrost typu +5%. Tu masz bardziej realnie, a nadal 50% jest 21fps na 32fps. Average się w VR nie liczy tak bardzo jak te 1% lows. Nawet 0,01% lows nie są bez znaczenia, choć wyniki typu +100% to bym radził tutaj odrzucić. 32fps. Jeśli headset ma tryb 72 czy 75Hz to od 32fps już bardzo blisko do 36 czy 37fps wymaganych do załączenia reprojekcji (wtedy ruchy głowy są w 72fps a sama gra w 37, plus ewentualna interpolacja). Dla lotów na większej wysokości jest to już do zaakceptowania przez wielu fanów flight simów. Osobiście wolałbym niższe ustawienia i pełną płynność przy lataniu bardzo nisko, bo mi akurat ten typ grania w "samoloty" daje najwięcej frajdy. Jednak zauważyłem, że zdecydowana większość fanów poważnego podejścia do flight simów, zadowala się 45fps a nawet 30 z interpolacją klatek. Bardzo ciekawe jest co gość mówi o graniu w 75fps bez reprojekcji. Na 5090 możliwe, na 4090 nie bardzo. Ogólnie jak ktoś celuje w VR z tych o najwyższej rozdziałce, to 5090 to mus. A jak ktoś celuje w 4K na oko (co daje jakieś 3x tyle pikseli ile w 4K na monitorze + wymagany wyższy framerate) to 5090tka jest zgodnie oceniania jako karta zdecydowanie za wolna do wykorzystania potencjału ekranów i optyki w pełni. Ktoś grający na Queście 3 czy VR sprzed kilku lat ala Valve Index, na pewno nie zobaczy tych +50% w praktycznych ustawieniach. Ale jak ktoś ma VR1, Beyond 2, Pimax Crystala czy najnowsze cuda z 4K na oko, to śmiało można mówić: 5090 jest 50% szybsza.

-

Piszczenie kart za 3000zł to skandal. Piszczenie kart za 20000zł to powinno być zwyczajne przestępstwo - traktowane tak z uwagi na prawa klienta i instytucje. które powinny się tymi prawami zajmować (realnie, a nie jak obecnie) Niestety w obecnej rzeczywistości, w której żyjemy, kompletnie nierealne.

-

Po spędzeniu kilkudziesięciu godzin przy sterowaniu kontrolerem w Queście 2 - śledzenie jego pozycji, nie granie gałką jaka jest na nim - nie mogę się z tym zgodzić. Chyba, że na czymś jest 3x lepsza precyzja i responsywność niż na Queście 2 w Ultrawings 2 w standalone. Może na Lighthouse'ach jest tak drastycznie lepiej? No i te rozglądanie się to przecież spora część frajdy z VRu. Nie raz zginąłem bo się odwróciłem żeby coś obejrzeć, albo wycelować z pistoletu w misjach w UW2, bo gra przestała odczytywać kontrolę. Innym razem nawet gdy patrzyłem się przed siebie, gra potrafiła zgubić sterowanie, co kończyło się oczywiście rozwaleniem o ścianę czy skałę. Tutaj występowało to sporadycznie i zakładam że możnaby to naprawić samym usprawnieniem softu. Ale i tak, nie ma to jak fizyczny joy. Responsywność i precyzja jest o wiele większa, a dla początkujących wręcz ogromna, bo sterowanie bez joysticka wymaga nauczenia się jak "ostrożnie" trzeba się z tym wirtualnym drążkiem obchodzić. O właśnie. Szybkie sterowanie. tutaj też to sterowanie psuje zabawę, bo trzeba o wiele więcej czasu poświęcić zanim się "wyczuje" maszynę i jej możliwości oraz reakcję na stery. W ogóle całe sterowanie troszkę "pływa" w porównaniu do grania na fizycznym sprzęcie. Zresztą to nawet nie ma jak oddać efektu "wracania" drążka do pozycji neutralnej. Może jakby zrobić z kilku listewek i gumki oraz kija od szczotki i go użyć w sterowaniu opartym o tracking samego headsetu Gdyj akość, szybkość i precyzja pójdą mocno do przodu, to wtedy to będzie miało więcej sensu. Oczywiście imersja w operowanie tym co widzimy w wirtualnym samolocie to też świetna rzecz i sam zakres ruchów drążka w dwupłatowcu, gdzie nieistniejący drążek można przesuwać o 30cm, zamiast grać na tradycyjnym joysticku do kompa, to też są plusy. Sumarycznie jednak fizyczny sprzęt obecnie jest wielokrotnie lepszy. Najlepiej jak jest zaawansowany system "blend in" gdzie fizyczny joystick widzisz w grze, albo przynajmniej wycięta "dziura w VRze" przez którą widać kontroler. Wtedy np. kontrola na joyu fizycznym, ale mimo to pełna obsługa śledzenia dłoni do operowania wszyskimi przyrządami w kokpicie.

-

W MS FS 2020 i 2024 tam, gdzie rodzielczość mocno przekracza możliwości 4090tki, jest wielokrotnie po +50%. Tam gdzie to CPU przyblokowuje, jest 20-25%. Jak ktoś mnie kiedyś zobaczy, że twierdzę, że 5090 jest 50% szybsza od 4090 to dlatego, że w VR faktycznie jest.

-

Uuu.. To porażka w grze na PC. Imersja imersją, ale jednak responsywność i precyzja kontroli na kontrolerach VR to póki co słaby żart No no, na szczęście przypuszczenia się potwierdziły - solidne +50% względem 4090tki jest tam, gdzie brakowało najbardziej GPU. Na te 150% nie liczyłem, mimo jakichś głupich testów w głupich ustawieniach. 5090 to jedyna karta tej generacji RTXów, która nie jest pośmiewiskiem w kwestii wydajności względem poprzedników. Szkoda, że na 7200zł za 4090 + 50%, czyli 10700zł za rozsądny model 5090tki, to nieprędko. Ale jeśli spadnie poniżej tego, zacznie się realny postęp. Póki co bardzo dobrze, że zrobili kartę o 50% szybszą w VR. Szczególnie jak pomyśleć, że większy FOV dokłada bardzo dużo do wymagań tak CPU jak i GPU. No może poza obliczeniami fizyki i wszystkiego w simach.

-

DEI, LGBT i poprawnosc polityczna w grach

VRman odpowiedział(a) na Roman_PCMR temat w Gry komputerowe (PC)

Apropo. To jest niesamowite, że kiedyś prawactwo nienawidziło Monty Pythona, bo ich celnie wyśmiewał, a teraz lewactwo nienawidzi tego, co w urywku wyżej. I też ich tu Monty celnie wyśmiewa. Chyba najlepszy dowód na to, że jak tacy ludzie mówią o komedii i wolności słowa, to należałoby słuchać. (Cleese'a konkretnie) -

Tak tak, wcale nie relatywizuje sytuacji. To, że po stronie Rosji też giną niewinni nie zmienia faktu, że każda śmierć jest na rękach ruskich. Także śmierć od Ukraińskiej rakiety, bo gdyby Fiutin nie wymyślił, że fajnie będzie zaatakować sąsiada, to żadnych rakiet lecących w stronę Rosji by nie było. Chcesz ich żałować, to żałuj efektów propagandy. Nie mieliby ofiar, jaky przeciętny cywil w Rosji nie miał kisielu w głowie, przez który odczłowiecza Ukraińców i usprawiedliwia to co robi Fiutin, to efektem tego właśnie potem może być utrata bliskich gdy Ukraińcy ślą rakiety. Ale dopiero efektem. Równie dobrze możesz pisać, że biedny nożownik, on też cierpi, bo się niechcący pociął i teraz go palec boli. To za Fiutinem idą śmierci niewinnych, jeszcze przed atakiem na Ukrainę. Jakby nie on, nie ginęliby ani po jednej, ani po drugiej stronie. To nie jest jakiś "konflikt", to nie "jedni mają za uszami i drudzy mają za uszami". Takie relatywizowanie za to usłyszysz bardzo często u proruskich "dziennikarzy". O tym, że "przecież po obu stronach giną" też.

-

Nie rozumiałem skąd taka reakcja. Więc odwinąłem posta hubia. A tam: Aha. No tak. Skasowałem to co napisałem dalej, bo do niego nie dotrze, a innym zmarnuję czas oczywistościami.

-

Styl wypowiedzi może mam, choć tego nie wiem. Nie widzę niczego mentorskiego lub "prorockiego" (mówi się proroczego) w tym co napisałem. Dobra. Napiszę specjalnie mentorski tonem teraz. Ten jeden akapit i pierwszy raz w życiu świadomie, z premedytacją: Tego typu teksty to sobie daruj. Za to może spójrz na siebie i zapytaj czy nie masz problemu czasem z przyswajaniem opinii drastycznie innych od swojej własnej na dany temat. Takie chamskie wykręcenie czyjegoś punktu widzenia i opinii jest dość często spotykane, ale nie bardzo ma związek z tym co ja napisałem. Jeśli nie przeszkadza dłuższy akapit to chętnie wyjaśnię czemu: Nie jeden ja wiem. Wiele osób wie. W tym np. pracownicy studia Asobo, które wydało jedną z niewielu gier na PS5, gdzie widać że priorytetem była zabawa u gracza a nie brandzlowanie się programisty/grafika, który uznaje granie w zręcznościowe gierki za zabawę dla dzieciarni, a on to poważny gracz i może conajwyżej pograć w coś wymagające intensywnego móżdżenia, albo filmo-gry gdzie jest wciągająca i wzbudzająca silne emocje fabuła (ci ludzie za dekadę będą przekonywać, że cloud gaming to przyszłość, że ma masę zalet i że jak jesteś przeciw to jesteś dziwny i się wymądrzasz, bo przecież panowie w korpo wiedzą lepiej. Nie wiedzą. Zobacz na reklamę nowego Jaguara albo Budlighta. Zobacz na wyniki finansowe marek typu Star Wars. Tysiące ludzi wiedzą lepiej, ale nikt w corpo ich nie słucha. Dlaczego? Bo w korpo są debile? Nie. Bo nie rozumieją targetu, dla którego oferują swoje produkty, lub mają inne priorytety. Tak jak Meta mogąca rozwinąć porządnie gaming VR, ale uznała, że lepiej się skupić na "fashion & lifestyle". Dlaczego? Bo są tacy głupi? Znowu nie. Bo wyciągnęli błędne wnioski z błędnie zestawionych danych, bo im zabrakło zrozumienia tego co sprawia, że ludzie chcą grać w gry. Ich te rozumienie interesuje tylko w tym sensie, żeby przyciągnąć gracza do gry, która będzie z niego doiła na mikrotransakcjach. I tutaj mamy Microsoft i Sony. W PS3/PS4 Sony inwestowało w gry takie, które były robione z myślą o graczach core. Gracz core rozumiał, że Playstastion da więcej fajnych ex'ów. I dlatego Xbox przegrał walkę z PS3 i z PS4. A teraz Sony dołączyło w swoim podejściu do MSu i przestawiło wajchę w 100% na "robimy dla inwestorów, a nie dla graczy" i exów "nie ma", za to są ogromne wydatki (i także wtopy finansowe) gier GAS czyli "live service". I znowu - jakbyś tak przerzucił analogię, to byś napisał, że przecież tam pracują mądrzy ludzie. Na pewno wiedzą lepiej. A jednak.. ci durni gracze, szczególnie ci z popularnymi kanałami na YT potrafią na 2 lata przed premierą gry powiedzieć, że "ta gra/film/serial będzie porażką". Jakoś wiedzą. To nie jest wiedza dla geniuszy z IQ 200 czy ile tam ma geniusz. To po prostu wiedza kogoś kto jest fanem danej marki od lat i wie za co on i reszta fanbase'u daną markę polubili i byli jej wierni przez dekady. Jeśli zamiast George'a Lucasa dasz do szefowania SW jakąś osobę, dla której SW to filmik dla dzieciarni, gdzie wystarczy dać jakieś machanie świecącymi mieczykami i dobre efekty specjalne aby zarobić miliardy, to się to nie uda. A dalej dochodzimy do sytuacji w AMD. Tutaj jest pełna mobilizacja i nakierowanie się na AI, bo widzą ile kasy trzepie Nvidia. Nawet jakby AMD wiedziało świetnie co należy robić, to i tak by obecnie tego nie zrobili, bo każdy programista oddelegowany do sterowników czy technologi tylko do gier, to wielki ból i "a czemu Franek nad AI nie pracuje?! Obecnie nie mamy nawet projektów GPU dla graczy. Blackwell to policzek w twarz graczy. Zero zmian, tylko ej aj. Ale za to wyższe ceny. Kończąc - nie trzeba być geniuszem, żeby zauważyć, że subkultura graczy PC rozkwitała gdy PC był atrakcyjny i oferował wiele za rozsądne pieniądze. Może i 40latkowie grający na PC mają kasę na rtxa 5080 (na 5090 nie oszukujmy się, tylko ułamek) ale co jak oni wymrą? Gdzie następne pokolenia? Ano nigdzie, bo ci się wychowają na konsoli+cloud gamingu. Jak już raz daną grupę ludzi się straci, to się tego nie da od tak odtworzyć. Nawet jakby za 4 lata nagle karty typu 5090 kosztowały 200$. I tak w ciągu roku się nie odbuduje tego co rujnuje obecna, chora sytuacja.

-

Jak "dla dziadków"? Serio wolisz 720p czy 1080p upscallowane cudnym AI do 4K zamiast prawdziwego 4K? Że się takie karty nie pojawią, to nie musisz pisać, Kapitanie Obvious. Przecież wiadomo, że firmy określające się jako "AI company" nie zrobią kart tylko dla tak słabego dla nich powodu jak "to by wyszło graczom i branży gier na dobre". 4/5 ceny 5090tki wynika z tego, że jest tam AI. Bo po pierwsze za tyle kupią tą kartę nie-gracze, a po drugie koszty R&D to w 90+% właśnie to AI w przypadku Blackwella. Gdy zwolennicy AI się cieszą, że NV dała model Transformer który dał poprawę za darmo, w tym samym czasie te AI w sumie niszczy kompletnie dostępność kart i winduje ceny o sporo więcej niż je obniża ta "gratisowa wydajność" jaką dał DLSS4 Dla mnie jedyny sens w zakupie takiej karty tylko do gier, to VR, a tam.. o kant kuli mogę sobie te całe ej-aje rozbić, chyba że jestem fanem symulatorów lotu i opinii, że 36fps to w sumie jest super, a TAA jest ideałem ostrości. Dosłownie ZERO korzyści z PT i AI, a VR to jest coś, gdzie 5090tka jest sporo za wolna. A potem wychodzi szycha w korpo i mówi "nie wiemy czemu, ale VR nie zdobyło popularności". Bo na karcie za 5000 możesz sobie pograć z pikselozą ala Playstation 2 ogrywane na 32" CRT TV z odległości 1.5m. Nie dla dziadków. Dla fanów VR, a dla posiadaczy OLEDów (do HFR). Dla graczy, którzy by chcieli za 5000zł kupować wydajną kartę a nie odpowiednik 1060tki. W HFR te AI w ogóle się do niczego nie nadaje gdy klatka następuje 2ms po poprzedniej. Nie da rady tego policzyć odpowiednio szybko, co pokazał nawet filmik demonstrujący te badziewne "neural texture compression" gdzie spadki przy 30fps może i są akceptowalne, ale przy 400fps sam ten algorytm AI zjada większą część wydajności. I tego się nie przeskoczy. Dziś mamy AI uspcallingTo co dziś się liczy 5ms nie da się policzyć w 0,5ms, a nawet te 0,5ms oznacza przy 500fps koszt aż 25% wydajności. A to tylko upscalling. Obok już kiełkują AI wspomagacze dla PT, gdzie cienie mają 0,5fps (zmieniają się po 2 sekundach ;)) i zaraz będą następne "cudowne technologie", które np. kosztem 40% wydajności w 240fps, pozwolą zaoszczędzić wydawcy gry kilka dolarów na hostingu, bo mniej danych, co oczywiście nie wpłynie w żadnym wypadku na obniżenie ceny gry dla gracza. AI i PT jest nam wciskane czy nam się podoba czy nie. I na pewno zostanie wciśnięte. Ale nie udawajmy, że to dla naszego dobra, że to w sumie lepiej, albo że się inaczej nie da. Da się, ale nikt tego nie zrobi, bo NV zarabia kokosy na AI, a AMD nie rozumie, że to otworzyło dla niej niszę, która mogłaby być zabezpieczeniem na wypadek jakby przyszłość przyniosła porażkę w konkurowaniu na polu AI z większymi firmami. A spora szansa, że poniosą, bo NV i inne firmy mają na to znacznie większe budżety. Tylko, że już mija 5 lat jak chore ceny GPU i inne niedogodności wybijają graczy PC i za następne 5 lat będzie zniszczona już "subkultura" pecetowców. Młodzi nie będą nawet wiedzieć co oznacza granie PC, jakie daje zalety i po co w ogóle mieliby kupować wydajnego desktopa do gier. I jak w 2035r. AMD splajtuje lub zostanie sprzedane za grosze jakiejś chińskiej korporacji, to będą mogli mieć pretensje tylko do siebie, że woleli gołębia na dachu zamiast wróbla w garści. A gracze.. a gracze będą sobie grać w gry strumieniowane z serwerów zwanych chmurą. Po wejściu w chmurę z wódki w łaźni na pół godziny, może nawet nie będzie przeszkadzać wtedy kompresja i input lag. Ale przynajmniej będzie nowocześnie i postępowo. z PT i z AI.

-

Pytasz go czy gra w te symulatory lotu w 2D czy w VR. A odpowiedź poznasz po zadaniu sobie takiego prostego pytania: - czy w tych grach podczas lotu można w kabinie pilota pograć w pingla? Wychodzi na to, że lata w 2D

-

przejście w "3D" porównywać do RT? Bez jaj. Nieliczni szli w 3D, bo częstokroć nie miało to po prostu żadnego sensu i oznaczało regres. Tu jest to podobieństwo do RT. W sensie, że zachwyt technologicznych nerdów w studiach developerskich przesłaniał im to co ważne - gameplay i atrakcyjność dla gracza, a nie nerda, który 10 lat wcześniej przestał grać w gry i 3D go w roku 1995 interesowało bardziej z punktu widzenia wspaniałej, niedostępnej wcześniej technologii niż z punktu widzenia gry. Pchanie takiego Croca w 3D to była jakaś kompletna porażka. Podobnie z Earthworm Jimem i wieloma innymi. - 3D kasowała artyzm i piękno grafy 2D. Akurat wtedy gdy osiągnęliśmy w 2D poziom bliski pełni możliwości. Porównajcie choćby Raymana do Raymana 2. Jedynka wygląda milion razy lepiej w 2D niż ta bide z nędzą w 3D. I żeby nie było - Raymana 2 przeszedłem pod koniec lat 90tych i sama gierka spoko. Ale wizualnie? Bez porównania. Dlaczego dziś się mówi, że 25-35 letnie gry 2D się "jakby zestarzały lepiej" od 25-35 letnich gier 3D? Ano dlatego, że teraz je potrafimy ocenić tego chwilowego zachwytu nad technologią, jaka nam wtedy towarzyszyła. Gdy już w latach 80tych i 90tych ludzie robili gry "lecisz i strzelasz wgłąb ekranu" w ten sposób: Technologiczne geeki, których zupełnie nie interesowało to, jak fajnie się będzie grało w ich grę, serwowali nam takie coś: Albo jeszcze gorzej. Tragicznie brzydka oprawa, w porywach 15fps, a bardzo często i 5-10fps, tragiczna mechanika przez idącą za tymi 5-15fps responsywnością. Ja pamiętam jak w 1990-91 się grało w pierwsze wektorówki. Samo to, że było "3D" nas jarało. Oczywiście. Miało to swój urok. Ale obiektywnie? To była pomyłka. 3D na komputerach i konsolach z 1985-1992 kompletnie nie powinno mieć miejsca. Ale istniało. I psuło gry, bo mimo, że moja 386 przerzucała polygony znacznie sprawniej niż Amiga 500, to jednak dziwnym przypadkiem grało się znacznie lepiej w Lotusa na A500 niż w Test Drive III na moim PC. Na Amidze też się przeszło Shermana M4, bo był w "3D" ale jakoś to nie w niego graliśmy wielokrotnie. Z jakiegoś powodu woleliśmy jechać czołgiem lub do nich strzelać w grach typu SWIV czy Silk Worm. Nawet na PSX (dla niekumatych: Playstation 1) w wielu grach był niedostatecznie wydajny, aby te gry miały w tym 3D sens. A pamiętacie Syndicate Wars? To dwójka, która na sprzęcie 2-4x szybszym od mojej 386, wyglądała i chodziła gorzej niż jedynka u mnie. Tej grze tak potrzebne było 3D jak moje łysej głowie grzebień. Jednak poszli w to, bo 3D było trendy (jak obecnie RT) i przede wszystkim dlatego, że zadecydowała osoba, którą bardziej jarała technologia sama w sobie, a granie w gry już sporo mniej. (jak obecnie z RT, niestety) Już w 1995r. czytałem, że z 2D nie da się już nic wycisnąć, że to koniec. I tak samo pierdzielą dziś idioci z Digital Foundry odnośnie rasteru. Tymczasem dopiero na Dreamcasta pojawiły się gry 2D w 60fps z oprawą w wysokiej rozdzielczości, co nadal dawało możliwości, jakich w 1995r. nie było. Tamte 5 lat postępu to dziś 20-30 lat, bo postęp niestety wyhamował. Za 30 lat nadal będą gry w rasterze, które zmielą te gry w rasterze, które mamy dzisiaj. Weźmy takie gry jak Guilty Gear X na DC lub Alien Hominid na Xboxa - w sensie rozdziałki. A w sensie bogactwa detali weźmy choćby gry typu Earthworm Jim odpalany na TV CRT. Jim wyszedł w roku 1996r. A według "ekspertów" w 1995r. miał być przecież koniec 2D i brak możliwości dalszego rozwoju. Albo weźmy dzisiejsze Rayman Legends czy Ori and the Blind Forest. Te gry są technicznie w 3D, ale można sobie je łatwo wyobrazić w 2D. Jakbyśmy te gry pokazali w 1995r. tym co się zachłysnęli 3D i wypisywali w czasopismach growych, że już nigdy w grę 2D nie zagrają, bo to przeszłość i przyszłość należy do 3D, to by się im zrobiło łyso jak mi po czterdziestce w sensie dosłownym Dziś dla RT musimy pożegnać: - HFR i jego zalety. W tym te jakie idą za 480fps+, czyli żyletą w ruchu mimo trybu sample-and-hold - responsywnością, bo często trzeba grać w 30-40fps, nawet na highendowym PC w 1080p - wymuszanie FG i artefaktów oraz dalsze pogorszenie responsywności - postęp w responsywności, w sensie, że 20 lat temu nie dałoby się zrobić np. ścigałki z myślą o takiej responsywności jaką da się uzyskać np. robiąc grę tylko i wyłącznie pod PC z 9800x3d + 5090, celując w stabilne jak skała 300fps. Jak ktoś gra to mu nie przeszkodzi, bo nauczy się sterować z tym lekkim "wyprzedzeniem", ale nie-gracze którzy łapią za kółko w grach wyścigowych najpierw się wesoło obijają od bandy do bandy, bo input lag niestety istnieje i nie są do niego przyzwyczajeni. To tylko jedna z rzeczy, gdzie nowa jakość idąca za HFR by pozwoliła na postęp i poprawę. - wysoka rozdzielczość - PS5 i gry w 800p w 2025 vs. PS4 i Ridge Racer w 1080p 60fps. A, sorry, to nie PS4. To było PS3. :] - atrakcyjność stylistyki nierealistycznej. Realizm ma swoje plusy, oczywiście, ale jego brak też je ma. To będzie trudno zrozumieć osobom, które tego nie lubią, ale wiele osób, w tym ja, woli brak realizmu, np. w efektach "magii" czy "elektryczności" wokół postaci czy mieczy. W grze oświetlonej realistycznie, taki efekt wygląda do dupy w słoneczny dzień, bo tak byśmy to widzieli w realu. Tymczasem przy grze w rasterze bez realistycznego światła, te błyskawice i wiązanki "energii" są pięknie nasycone, pełne kontrastu i.. po prostu ładniejsze niż realistyczna wersja. Tutaj też wchodzi oryginalność i różnorodność, posiadanie własnego stylu wizualnego, duszy. Wiem co potrafią shadery, rozumiem że można zrobić grę stylizowaną na cell-shading w Unreal Engine 5, ale nawet zwolennicy teorii, że PT to bóg, muszą przyznać, że im realistyczniej, tym gry wyglądają podobniej. A gdy osiągniemy realizm i wszędzie będzie tak samo, to po prostu nam się znudzi. Szczególnie, że nierealizm potrafi być atrakcyjniejszy, mieć nienaturalnie piękne nasycenie kolorów czy całe światy wyglądają inaczej. Ja do dziś czuję atmosferę gry MDK bardziej niż w nowych grach przedstawiających inny, nieznany świat/planety. Podobnie nie wyobrażam sobie gier typu REZ gdyby tam było realistyczne oświetlenie i przyblakłe kolory. Nie wyglądałoby to jak wnętrze komputera, nie dawałoby uczucia bycia w jakimś innym świecie. Podobnie Far Cry i jego pierwsza plansza po wyjściu z jaskini. Do dziś to najfajniej wyglądająca rajska wyspa jaką widziałem. Mnóstwo emulatorów starych konsol dostaje mody do ray-tracingu i... traci cały swój unikalny klimat. I jeszcze się techgeeki brandzlują do tego (np. Zelda czy Mario na Digital Foundry - moim zdaniem to wygląda tragicznie źle, kompletnie do bani i zabija całą duszę jaką miały oryginalne wizualia. Nawet Halo - wolę wygląd starych części. Jest mowa o przyszłości i technologii innych ras, a w nowym Halo mi serwują brud, rdzę i rysy na pancerzu, a efekty energii wyglądają jakby ktoś na dworzu zapałką pierda podpalił, a nie jakby to była technologia obcych. Chyba można założyć, że dali radę opracować taką farbę, która nie schodzi. Do tego oczywiście realistyczny kurz i wszystko brzydkie. Co ciekawe w tego typu grach czasami zostawiają stare oświetlenie, o czym oczywiście nie zapominają potem pomarudzić Alexy z Digital Foundry. A czemu tak zostało w tym najnowszym Halo albo innej grze o podobnej mechanice i ustawieniu kamery? (już nie pamiętam teraz, chodzi o grę sprzed 2-5 lat) Ano dlatego, że postacie które są wyłączone spod oświetlenia, są podświetlone zawsze, więc "świecą" nawet jak wpadną w cień. I tu przechodzimy do - wpływ na gameplay. Te świecące postacie po prostu się przydają jeśli ideą gry jest celowanie, a nie szukanie przeciwników i chowanie się przed nimi. I przy realistycznej grafice odechciewa mi się grać w gry online, bo po prostu gówno widać. Wolę stare gry, gdzie widać wszystko fajnie. Camperom się nie podoba, ale przez to jest ich w grze mniej, co podnosi atrakcyjność gry dla wszystkich pozostałych, a szczególnie tym, którzy preferują czysty fun, a nie spuszczanie się nad wynikiem meczu - czyli np. "styl Rambo" i biegnę sobie postrzelać do kolegów, bo gramy z kilkoma, a wszyscy żłopią piwko i nastawiają się na śmiech i dobrą zabawę, a nie na to, że co chwilę będą musieć nic nie robić, wyczekując, albo ginąć od kuli wystrzelonej 3km dalej przez jakiegoś campera. A poza tym - koszt. Czemu dziś 5090 kosztuje 3500€? Bo ludzie kupują do AI. Jakby te GPU wykastrować z tego, co jest potrzebne do realistycznego oświetlenia, to ta sama wydajność wypełniania pikseli, geometrii i tekstur, mogłaby kosztować 500€, a nie 3500€. Bo nie byłaby taka karta atrakcyjna dla ludzi szukających sprzętu do obliczeń/AI/ray-tracingu. Przez tą durną pogoń za realizmem, karta mogąca kosztować 500€ dziś kosztuje 1500€. Po czym włączają nam AI i każą klaskać, że dzięki temu na tej karcie za 500€ uzyskamy wydajność jak na karcie za 1000€. AI i RT to nie jest żadna przyszłość. To jest RAK toczący branżę. To są technologie wspaniałe dla innych branż jak np. rendering i modelowanie 3D, tworzenie filmów ala te Pixara. AI też się przyda w wielu miejscach. Ale w grach lista zalet pozostanie ograniczona, przy ogromnej liście wad i kosztów (nie tylko "kosztów" w sensie dosłownym) Niestety jest gorzej. W 1990-92 sprzęt kompletnie się do 3D nie nadawał, ale wystarczyły 4 lata do momentu, gdzie coś się już na tym zrobić dało, a zaledwie 8-10 lat do momentu gdzie już to miało sens w pełni (Playstation 2) Tymczasem z RT/PT jest tak, że w 2018 wymyśliłem, żeby 2080ti nazywać takim "S3 Virge" w ray-tracingu. Falstart. Miałem rację, że falstart, ale nie miałem racji, że tamto to był S3 Virge. Nawet 4090tka w PT to nadal poziom S3 Virge'a. A 5090tce nadal daleeeko do tego rozsądnego minimum. Co gorsza, postęp z RT/PT zamiast przyspieszać, wydaje się zwalniać, a kolejne cud technologie opierają się na... eliminowanie detali. I fajnie, po co marnować moc na te elementy, których nie widać. Tylko że jak sobie z tego zdamy sprawę, to prawdziwego postępu w wydajności.. praktycznie nie ma od wielu lat. To znaczy, że jeśli chodzi o PT mainstreamowy gaming czyli konsole i GPU za poniżej 1000€ pozostaną w tym etapie S3 Virge'a na dwie dekady. Tymczasem od S3 Virge'a do 3dfx VooDoo 4MB minęły zaledwie 2 lata. Nawet mniej. Postęp galopował. Zaraz po Virge'u był Matrox Mistique, który pozwalał na pełną płynność w 640x480 w kilku grach z akceleracją, oferując niespotykane wcześniej efekty jak piękne przezroczyste obłoki dymu w ścigałce (nie pamiętam już tytułu. Destruction Derby 2?) A dosłownie kilka miesięcy później człowiek już czytał recenzję w Secret Service Diamonda Monster 3D (3dfx) Wad przejścia w 3D było sporo, ale nie trwało to długo. A teraz będziemy się kisić w rozmytym, upscallowanym szajsie przez co najmniej 15, a raczej 20-30 lat od momentu ogłoszenia tej gówno-rewolucji w 2018r. Na S3 Virge'u ograłem Plane Crazy w 400x300 (16bit color, 60fps, rozmycie tekstur, FAJNIE!) i trochę pograłem w MDK w 320x240 (w tej wymuszonej rozdziałce przynajmniej dało się jakoś pograć mogąc cieszyć się nowoczesnym rozmyciem tekstur). Dałem za tą kartę 400zł. W tym połowa albo więcej była za funkcjonalność 2D, więc sam koszt nowego ("akceleracji 3D, która była "deceleracją";)) to 100-150zł. Dziś dokładnie tak samo odbierałbym granie w Indianę Jonesa czy Cyberpunka 2077 z PT na 5090tce. Za wolno, żeby pograć (bo stałego 120fps bez FG nie ogarnia nawet) ale akurat, żeby sobie pograć i pooglądać nową technologię. Z tym, że zamiast 150zł (plus inflacja) dziś krzyczą 10 000zł. A przydatność podobnie mizerna lub prawie żadna, z kilkoma wyjątkami. Na S3 wymieniłem dwie gry. Jeszcze w Tomb Raiderze chyba to uruchomiłem. Nie pamiętam. A.. i w Jedi Knight. I Terminal Velocity chyba nawet w 640x480 na tym na Virge'u chodziło. Nie przypomina Wam to czegoś? No przecież dokładnie tyle jest gier z RT/PT, wartych obejrzenia. Indiana, Cyberpunk, może ze 2-3 jeszcze na siłę.. i to w sumie tyle. W reszcie żadnego szału to nie robi, gry nie odmienia.

-

Ja pierwsze słyszę. W ogóle nie grałem na PC w latanki póki co, ale może to się przyda: Zależy czy kręci Cię sama symulacja, zdobywanie wiedzy o tym jak faktycznie się lata samolotem, operowanie przyrządami, walka z prądami powietrznymi, gadanie z kontrolą lotów itd. czy może sam lot. Jak sam lot, to nie potrzebujesz niewiadomo jak skomplikowanego sima. Za to przyda się fajna grafika do cieszenia oko krajobrazami. Tylko joystick za minimum 150zł konieczny, bo bez tego sporo z funu uleci (pun niezamierzony ;)) Zapytałem GPT co ludzie polecają Dziwne, że Ultrawings 2 nie wymienił. Ta gra jest gdzieś pomiędzy arcade a simami, zdecydowanie bliżej arcade, ale jednak też dość daleko od pełnego arcade.

-

Oby nie. Memiczność Ventusa już prawie stworzyła nowy, fajny mem, a takie coś by wszystko popsuło!

-

DEI, LGBT i poprawnosc polityczna w grach

VRman odpowiedział(a) na Roman_PCMR temat w Gry komputerowe (PC)

John Cleese "... and of course.. moderates" Faktycznie prawdziwe mimo upływu dekad. John w ogóle nawet w podeszłym wieku zachował przytomny umysł. Fajnie krytykował choćby niszczenie wolności słowa i wolności żartu na rzecz stawiania na piedestale czyichś emocji (lub często urojeń) z gatunku "I'm offended!". -

@Phoenix. Jakie największe odkąd powstała architektura Zen? O czym ty piszesz, człowieku? Jesteś w wątku o PS6, więc tu skupiamy się na wydajności w grach. Tylko. https://www.tomshardware.com/pc-components/cpus/amds-zen-6-based-desktop-processors-may-feature-up-to-24-cores Tyle same L3 na każdy rdzeń. Więcej rdzeni na CCD = nieprzydatne do gier. W grach więcej niż 8 jaj się do niczego nie przyda Rdzenie o niskim poborze prądu - to przecież nic nie da, bo w żadnej grze tego sensownie nie da się wykorzystać. Przynajmniej nie do tego, na czym skorzystałby gracz, bo do liczenia jakichś DRMów i tego, co wrzucą tylko dlatego, że mają je do dyspozycji, to oczywiście. I pewnie do tego, aby konsola brała mniej prądu w menu lub przy oglądaniu filmów lub pobierania aktualizacji. Jak wiesz o jakichś rewolucyjnych zmianach to wrzuć linka. edit: Jeszcze NPU. Tylko że tutaj będzie APU więc ten segment będzie w GPU a nie w CPU.

-

Nie ze wszystkim się zgadzam, ale info ciekawe.

-

Boga sobie ludzie wymyślają, bo albo czegoś nie rozumieją (pierun szczelił w somsiada, a on pendził bimber wienc to na pewno karo bosko!") albo z potrzeby znieczulenia przed strasznością tego niedoskonałego świata i nieuchronności śmierci i zapomnienia dla wszystkiego i wszystkich. Albo przez jedzenie dziwnych grzybów lub łażenia za długo po pustyni w słońcu. A co do raju na ziemii, to osobiście myślę, że aby ludzkość tak poszła do przodu w sensie moralności i postępu ogólnego, jak to pokazuje np. serial Star Trek, to byśmy musieli opanować metodę na wieczne zdrowie i nieśmiertelność. Inaczej wiedza "życiowa" się ulatnia wraz ze śmiercią danego pokolenia i powtarzane są te same błędy. Poza tym wymagałoby to niemożliwego do stworzenia systemu edukacji i izolacji nowych ludzi od starych ludzi, niejako "wytresowania" ich do bycia dobrymi. W przypadku braku kosztu dla kogoś nieśmiertelnego, praca która da korzyści komuś innemu byłaby podejmowana chętniej, a dzięki wiecznemu zdrowiu więcej by zostawało energii na cieszenie się życiem po pracy. Wtedy niech np. roboty wykonują 90% pracy, a reszta niech pracuje w czymkolwiek co jest potrzebne lub porządane. Trzebaby też jeszcze zadbać o jakiś nadzór. Kolejna rzecz z tych kompletnie nierealnych. Ogólnie raju na ziemii to się zrobić prawie nie da, a jakby się miało dać, to wymuszałoby to masę działań i zasad wątpliwych moralnie. Prawda jest taka, że mieliśmy fuksa, że akurat tak sie poukładało trochę atomów, że zaistnieliśmy. A potem przestaniemy istnieć i tyle. Nie ma żadnego brodacza w niebie, który się zaopiekuje naszą "duszą". Duszy też nie ma. Jest biologiczny komputerek. Jak się popsuje to przestajemy istnieć, i to w sumie tyle. PS. Żółw się rusza!

-

Wstawiasz wywiad z Tuckerem Carlsonem i się pytasz czy coś w nim to prawda? Przecież on jest jednym z głównych propagandystów kremlowskich operujących w USA. Myślisz, że bycie jedynym zachodnim dziennikarzem, który sobie pojechał w 2024r. zrobić wywiad z Putinem, to przypadek?