SebastianFM

Użytkownik-

Postów

708 -

Dołączył

-

Ostatnia wizyta

Treść opublikowana przez SebastianFM

-

Bardzo trafnie podsumowałeś te twoje pseudo mądrości. A niby w którym miejscu jej nie mam? Co takiego było na starym forum? W jakich grach, na jakim procku? Zauważ, że napisałeś w dyskusji o 14 generacji i w tym przypadku wszystkie twoje stwierdzenia odnośnie wydajności, wydajności na wat i jakichś problemów są po prostu nieprawdziwe. Nie byłbyś sobą gdybyś czegoś nie wymyślił. Nie ogarnąłeś czy specjalnie udajesz, że nie zauważyłeś, że to nie było porównanie z wyłączonym i włączonym HT. Przy włączonym HT masz napisane, że były wyłączone rdzenie E a przy wyłączonym HT było włączonych 16 rdzeni E i pokazałem, że takie ustawienie daje lepszą wydajność i też lepszą wydajność na wat. Uzupełniłem wyniki o pozostałe konfiguracje. Cyberpunk 2077, 1080p, ustawienia Ultra. 8 rdzeni P z wyłączonym HT, 0 rdzeni E. 125,3 FPS, pobór mocy przez CPU 128,2 W, https://i.imgur.com/HzGCfeo.png. 8 rdzeni P z włączonym HT, 0 rdzeni E. 134,6 FPS, pobór mocy przez CPU 154,8 W, https://i.imgur.com/eWBdKLF.png. 8 rdzeni P z wyłączonym HT, 16 rdzeni E. 141,4 FPS, pobór mocy przez CPU 149,8 W, https://i.imgur.com/62bVUWT.png. 8 rdzeni P z włączonym HT, 16 rdzeni E. 136,7 FPS, pobór mocy przez CPU 174,7 W, https://i.imgur.com/HxiqEh8.png.

-

Sterowniki GeForce & NVIDIA App - temat zbiorczy

SebastianFM odpowiedział(a) na daerragh temat w Karty graficzne

@leven, to żaden skrót, poczytaj sobie co to znaczy profiler. -

Sterowniki GeForce & NVIDIA App - temat zbiorczy

SebastianFM odpowiedział(a) na daerragh temat w Karty graficzne

@leven, ten program to nie jest profiler. 😊 -

@zozolek, myślisz, że jesteś taki cwany? 😁 Wiedziałem, że ktoś zaraz wyskoczy z tą grą tylko, że to jest naprawdę wyjątek. Ułomni programiści, którzy pisali tą grę to powinni mieć dożywotni zakaz korzystania z komputera, jeżeli do tej pory tego nie poprawili. Poza tym problem z przycięciami w tej grze występował tylko na Windows 10.

-

@sideband, no niestety znowu wychodzi na to, że teoretyzujesz i powtarzasz jakieś mity. Powiedz mi dlaczego jakoś ja gram we wszystkie gry z włączonymi rdzeniami E na i9-13900K, mój brat tak samo na Core Ultra 9 285K, i nie trafiliśmy jeszcze na grę w której byłyby z tym jakiekolwiek najmniejsze problemy? Z wydajnością i wydajnością na wat też nie masz racji. Przykłady, specjalnie teraz sprawdziłem. Cyberpunk 2077, 1080p, ustawienia Ultra. 8 rdzeni P z wyłączonym HT, 16 rdzeni E. 141,4 FPS, pobór mocy przez CPU 149,8 W, https://i.imgur.com/62bVUWT.png. 8 rdzeni P z włączonym HT, 0 rdzeni E. 134,6 FPS, pobór mocy przez CPU 154,8 W, https://i.imgur.com/eWBdKLF.png. Horizon Forbidden West, 1080p DLSS Q, ustawienia najwyższe. 8 rdzeni P z wyłączonym HT, 16 rdzeni E. 116,4 FPS, pobór mocy przez CPU 138,5 W, https://i.imgur.com/2zz8vVC.png. 8 rdzeni P z włączonym HT, 0 rdzeni E. 111,1 FPS, pobór mocy przez CPU 161,7 W, https://i.imgur.com/B0rcKVF.png. Może ty pokażesz jakieś wyniki? 😁

-

Niby czemu? Co to za skrajna teoria? Może jakieś uzasadnienie, czemu tak uważasz? Ja sam sprawdzałem działanie i wydajność wielu gier na różnych konfiguracjach rdzeni, wyłączonym/włączonym HT, różnej ilości rdzeni E. W żadnej grze nie było więcej FPS po włączeniu HT, jeżeli włączone było co najmniej 8 rdzeni E. Testy przeprowadzałem w niskiej rozdzielczości, żeby karta graficzna nie ograniczała FPS. HT mam wyłączone już od dawna. Przy wyłączonym HT można ustawić niższe napięcie o 0,05 V co wpływa na obniżenie poboru mocy. Niektóre gry nawet mają wyższą wydajność przy wyłączonym HT, ponieważ przy włączonym uruchamiają równolegle zbyt dużą ilość wątków przez co nie działają optymalnie.

-

To ty uważasz, że zmiana zasilacza naprawiła uwalony procek? Po prostu autor tematu zbyt szybko postawił diagnozę i okazała się błędna.

-

@Kris194, i jeszcze czujnik dymu. 😁

-

Jak naprawić 0.1% i 1% lows, mimo dobrego średniego fps? Od czego to zależy?

SebastianFM odpowiedział(a) na Keller temat w Karty graficzne

@sideband, a ty znowu to samo. Wytłumacz mi jedno, jak taki pomiar może być mało wiarygodny skoro odczytywane są zdarzenia (events) z systemu operacyjnego, każde rejestrowane z bardzo dokładnym znacznikiem czasowym? 🙂 Zdarzenia rejestrowane przy każdym wywołaniu funkcji Present przez grę. PresentMon, używany przez CapFrameX czy FrameView, tylko odczytuje te zdarzenia. Samemu też je można bez problemu odczytać, nawet bez dodatkowego programu. PresentMon to mógł mieć błędy w kodzie przy obliczaniu opóźnienia itp. a na pewno nie przy czasach kolejnych klatek. Kod źródłowy programu jest dostępny. RTSS nie odczytuje zdarzeń tylko hook'uje funkcję Present też dzięki temu ma dokładny czas każdego wywołania tej funkcji. Za pomocą NVIDIA Nsight Systems można sprawdzić nie tylko czasy kiedy gra skończy renderować każdą klatkę ale również kiedy klatka zostanie wyrenderowana przez GPU a także wyświetlona. Opowiadasz bzdury, że nie da się tego dokładnie zmierzyć. Najwyżej przyznajesz, że ty tego nie potrafisz. -

Jak naprawić 0.1% i 1% lows, mimo dobrego średniego fps? Od czego to zależy?

SebastianFM odpowiedział(a) na Keller temat w Karty graficzne

1% Low FPS i inne statystyki są obliczane na podstawie ostatnich czasów klatek z określonego przedziału czasu a nie od początku uruchomienia gry. W CapFrameX dla tych statystyk wyświetlanych podczas gry można nawet ustawić jaki to ma być czas, domyślnie jest 20 sekund. -

@Keller, tylko do testu, zamiast włączać FSR zmniejsz rozdzielczość do 1280x720. Czy to powoduje wzrost FPS czy jest tak samo jak po włączeniu FSR czyli bez zmian w wydajności?

-

Skoro po włączeniu FSR zmniejsza się użycie GPU a nie wzrasta ilość FPS to znaczy, że procesor jest ograniczeniem.

-

Oficjalny benchmark Monster Hunter Wilds

SebastianFM odpowiedział(a) na JacekRTX temat w Pomiar wydajności

@JacekRTX, po prostu fejkowe klatki nie liczą się do wyniku. 😁 -

Jak naprawić 0.1% i 1% lows, mimo dobrego średniego fps? Od czego to zależy?

SebastianFM odpowiedział(a) na Keller temat w Karty graficzne

To co napisałeś na pewno nie dotyczy CapFrameX, FrameView, NVIDIA Nsight Systems, itp. Po pierwsze te pomiary nie mogą być inne niż programowe, ponieważ mierzony jest czas w którym gra wywołuje funkcję Present. To tak w największym skrócie. Po drugie przy każdym wywołaniu tej funkcji w systemie operacyjnym jest rejestrowany Event z bardzo dokładnym znacznikiem czasowym. CapFrameX korzysta z PresentMon, który po prostu odczytuje te Eventy. To nie obciąża dodatkowo w żaden sposób podczas monitorowania. RTSS też zakłada hook na Present więc ma informację o dokładnym czasie każdego wywołania tej funkcji przez grę. To, że u ciebie występują problemy z przycięciami podczas monitorowania to nie znaczy, że tak jest u wszystkich. -

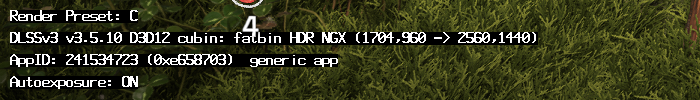

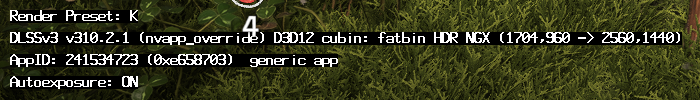

@leven, to nie ma znaczenia, co ci pokazuje Swapper, ponieważ on sprawdza wersję biblioteki jaka jest w katalogu gry. Włączenie opcji zastępowania bibliotek w nvidiaProfileInspector lub NVIDIA App powoduje, że nie jest ładowana biblioteka z gry tylko najnowsza wersja, którą sterowniki pobrały z internetu. Horizon Forbidden West mam i w tej grze to działa tak samo jak we wszystkich innych. Domyślnie. Po zmianie opcji w nvidiaProfileInpector. Ustawienia.

-

@Crew 900, pobierz najnowszą wersję programu.

- 923 odpowiedzi

-

Nie wiem jak NVIDIA App, ponieważ nawet jej nie instalowałem natomiast sprawdziłem, że po włączeniu w nvidiaProfileInspector opcji DLSS - Enable DLL Override to sterowniki ładują najnowszą wersję biblioteki zamiast tej, która jest w katalogu z grą.

- 923 odpowiedzi

-

- 2

-

-

-

@tgolik, https://github.com/Orbmu2k/nvidiaProfileInspector/releases Nie musisz się nawet bawić w dodawanie jakiegoś .xml.

- 923 odpowiedzi

-

- 2

-

-

-

@AndrzejTrg, biedaczku, a jak ty sobie radzisz jak trzeba jeszcze jakieś ustawienia w grze zmienić. 😁 Sprawdzałem i wystarczy tylko w nvidiaProfileInspector zmienić 2 opcje, żeby w każdej grze automatycznie był używany najnowszy DLSS z Preset K.

- 923 odpowiedzi

-

W przypadku Wiedźmin 3 trzeba. W najnowszej bibliotece DLSS domyślnym jest Preset K jednak akurat ta gra nie korzysta z domyślnego tylko ustawia Preset A.

- 923 odpowiedzi

-

Szczerze, to chyba tylko ciebie. Z dupy te pretensje do NVIDIA. Tylko tobie nie pasuje. To była świadoma i bardzo słuszna decyzja, żeby każda gra korzystała z własnej kopii biblioteki DLSS umieszczonej w grze. Dzięki temu nie ma żadnych problemów. NVIDII to się należą podziękowania po pierwsze za to, że nowy DLSS wciąż działa na kartach nawet sprzed 3 generacji a po drugie za to, że nie zmienili API i najnowszych bibliotek można używać nawet w grach, które od dawna nie były aktualizowane!

- 923 odpowiedzi

-

- 3

-

-

-

Na pewno będzie miał cenę z kosmosu. 😁

-

@Alonzo, nie sugeruj się tymi opiniami, że karta do wymiany. Sprawdź ją w innych grach.

-

Sterowniki GeForce & NVIDIA App - temat zbiorczy

SebastianFM odpowiedział(a) na daerragh temat w Karty graficzne

No właśnie tak. Co jest prawdziwego w tym zdaniu?