-

Postów

5 739 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

4

Treść opublikowana przez VRman

-

Obserwowane mają wyróżnioną czcionkę. Tylko na jasnym się wyrażnia, a na ciemnych ni cholery nie widzę różnicy. W dzień mam więc jasny, a przed snem przełączam. Poza tym na monitorze i w panelu NV są suwaki. Można niebieski skręcić mocno. Co do tego, że u Ciebie inaczej a u mnie inaczej wygląda to posłużę się cytatem: https://youtu.be/ShT93-pKMjA?t=3130

-

Polityka w Polsce i na Świecie - wątek ogólny

VRman odpowiedział(a) na Spl97 temat w Dyskusje na tematy różne

o matko bosko częstochosko... co ja czytam -

Wojny i konflikty zbrojne na świecie

VRman odpowiedział(a) na Camis temat w Dyskusje na tematy różne

Może nie aż tak, ale o powiązaniach ekooszołomów z Ruskimi też się świat dowiedział kilka lat po, więc kto wie. Tymczasem GPT na ten temat mówi tak: -

Jak pożyczyłem koledze monitor i musiałem grać na takim bez strobo to slashery są nudne jak w flaki z olejem. Przecież połowa funu w tych grach to oglądanie rozpierduchy. Albo żyleta w ruchu albo nie gram. Dlatego radzę spróbować jeszcze raz jak będziesz miał dostęp do ekranu który sobie z tym ruchem poradzi. Np. OLED 480Hz z symulacją CRT https://blurbusters.com/crt-simulation-in-a-gpu-shader-looks-better-than-bfi/ WYPAD Z TĄ POLITYKĄ Z WĄTKA O GRACH!

-

-

https://gamingbolt.com/ninja-gaiden-4-director-misses-old-style-of-3d-action-games-in-the-modern-era-of-soulslikes Wreszcie jakiś normalny dev przemówił z sensem. Walić soulsy. Nie mam na to zdrowia, czasu ani umiejętności. Ale w klasyki DMC, Bayonetty i Ninja Gaiden 1 grało mi się zarąbiście, z zastrzeżeniem, że w Bayo bywało a NG1 było nonstop trochę za trudno już wtedy. A dziś jestem 20 lat starszy i zgrzybiały, refleks zardzewiał, cierpliwość wyparowała, a pamięć na combosy i move patterns bossów przypomina tą Joe Bidena. No i dajcie mi spokój z tymi smętami. Dosyć szarych pustkowii, brzydoty i stylistyki rozpadu, zgnilizny i bestii z piekieł. Dawać coś lżejszego, w co się będzie fajnie grało. Najnowszego DMC muszę ograć. Jeszcze nie ograłem, ale nie szkodzi. Tego poprzedniego skończyłem jakoś 8 lat po premierze także to u mnie normalne

-

Wojny i konflikty zbrojne na świecie

VRman odpowiedział(a) na Camis temat w Dyskusje na tematy różne

Tym razem niepokojące/złe wieści https://www.komputerswiat.pl/aktualnosci/militaria/tajemniczy-atak-rosji-w-baze-ukrainy-uderzylo-kilkanascie-pociskow/7hbzblm -

https://blurbusters.com/displayweek-2024-news-4k-1000hz-monitor-exhibited-and-new-blur-busters-display-tester/ Niestety ani ten LCD nie miał sensownego 1000Hz, bo LCD powyżej 700Hz nie nadąży nawet na najszybszych TNkach, a na IPS sporo niżej (o VA nie mówiąc) ani ten OLED niestety nie ma tego 720Hz w natywnej. A szkoda, bo im prędzej marketing odleci w stronę 700+Hz, tym szybciej stanieją te mające "tylko" 480Hz. Te 700Hz OLEDy będą oczywiście lepsze od OLEDów 500Hz, ale pytanie skąd brać taki sygnał. Albo sensowne FG, albo używać do bardzo starych gier i symulatorów CRT gdzie więcej Hz pozwoli na lepsze symulowanie "wiązki świetlnej" CRTeka. No i kable. Dopiero co wszedł DisplayPort 2.0 80Gpbs, a lepszy standard to w kartach dopiero za dobre kilka lat. Może jakimś cudem już pod koniec 2026, ale wątpię czy przed 2028. Do 4K 700Hz 80Gbps nawet z DSC będzie za mało.

-

Wojny i konflikty zbrojne na świecie

VRman odpowiedział(a) na Camis temat w Dyskusje na tematy różne

Cóż za piękne nagranie A to tak, dobry argument. Mimo wszystko do znaczenia i przydatności tej pierwszej pajęczej sieci to daleko. Chyba, że się dowiemy o innych pociągach, które już długo nie pociągną. (o, jeszcze widzę dwa samoloty na lotnisku się ulotniły) -

Wojny i konflikty zbrojne na świecie

VRman odpowiedział(a) na Camis temat w Dyskusje na tematy różne

Nie no, bez przesady. Kilkanaście (skoro oni mówią kilkadziesiąt) czołgów i wozów opancerzonych to nie ta skala co rozwalenie tak ważnych rzeczy jak samoloty i być może A50 (ciekawe czy się dowiemy czegoś pewnego o tym czy oberwał na tyle, żeby było się z czego cieszyć) Co nie zmienia faktu, że info o tym pociągu cieszy. -

Polityka w Polsce i na Świecie - wątek ogólny

VRman odpowiedział(a) na Spl97 temat w Dyskusje na tematy różne

Ja pierdzielę. Jedni się ośmieszają wyzywając od faszystów, a ruskie wpływy z drugiej strony komentuje dziad, który albo sam jest pod ich wpływem albo nie ma pojęcia nawet o tym, że sam jest dla ruskich pożytecznym idiotą napędzającym ruskie fejki Normalnie jakbym oglądał zawody sportowe dla osób z zanikiem mózgu. edit: to komentarz do cytatu wyżej i chodzi mi o osoby ze screenshota, nie osoby na forum -

Nowy zasilacz MSI MPG A850G PCIE5.1 850W pod 7500F + 5070ti

VRman odpowiedział(a) na Lameismyname temat w Chłodzenie, obudowy, zasilacze i modyfikacje

Podłączyłbym znowu tego Shifta po tym jak komp ruszył. Mógłbyś się zdziwić. Nie mówię, że tak by było, ale szansa jest. -

oj oj tam. Ale jakie oświetlenie ryalystyczne!

-

-

Ale developer nie wyda Ci lepszego tenisa na np. sprzęt, który nie ma kontrolerów. Już dawno były plotki, że Meta rozważa headset bez kontrolerów. Moim zdaniem to się stanie. Nie wiem czy za rok, czy za pięć, ale obawiam się, że to nieuniknione. To będzie cios w plecy dla core gamingu, bo rękami to można się po dupie podrapać a nie w coś sensownie pograć. Już dekadę temu John Carmack to krawaciarzom próbował tłumaczyć, ale nie dotarło jak widać do wszystkich. A tłumaczył długo, szczegółowo i dość łopatologicznie.

-

Polityka w Polsce i na Świecie - wątek ogólny

VRman odpowiedział(a) na Spl97 temat w Dyskusje na tematy różne

Czytam ten wątek czasem i od dawna mi na przemian szkoda raz tych co łykają lewackie narracje i tych co łykają prawackie narracje. I z obu stron absolutne przekonanie, że ta ich narracja jest prawdziwa, a inne to fejki. Nie będę wymieniał ksywek, bo nie o to chodzi. Apeluję o zmuszanie się do oglądania mediów/źródeł strony, której nie lubicie i żeby być po prostu ostrożniejszym, bo strzelacie do swoich bramek paplając za swoimi bez weryfikacji, czym utwierdzacie swoich przeciwników i niezdecydowanych o tym, że nie jesteście wiarygodnymi dyskutantami. I dobra rada: Nie. Ci "wasi" to nie są "ci dobrzy". Dobrych (liczących się) partii nie ma i podejrzliwość jaką macie do partii, polityków i mediów, których nie lubicie, powinniście stosować do wszystkich. W tym do tych, których lubicie. -

O, patrzcie co znalazłem. Widzę, że nadal w Atlas OS dają tą opcję, zapytałem GPT o to i... A tu ze strony Atlasa: W skrócie: mimo zapewnień od 19 lat, nadal to może powodować przycinki w skrajnych sytuacjach i zastosowaniach niszowych. Czyli dokładnie tym czym mainstream określa VR. A teraz się rozpiszę: Naście lat temu trzymałem proca na wyłączonych funkcjach oszczędzania energii. Potem kilka lat później się ze mnie śmiali na forum. Bo przecież z tym już od dawna nie ma problemu. Po 2 latach okazało się, że jednak nadal bywają problemy. Po kolejnych kilku latach znowu się ze mnie śmiali i znowu argumentowali tak samo. I znowu okazało się, że jednak bywają problemy. A teraz się okazuje, że mogą być nawet na najnowszych procesorach. Oczywiście fachofcy grają w 4K ultra w 60fps i nie mają pojęcia o czym mówią, ale skoro wszyscy tak samo mówią a oni są weteranami, programistami, testerami sprzętu itd. to są najmądrzejsi. Na każdym forum tak. O moim kopaniu się z końmi będącymi tutaj autorytetami na temat wyników w testach w 1% i 0,1% lows nie będę nawet przypominał. Tymczasem jak mnie od 20 lat interesuje głównie HFR to ten aspekt pozostaje dla mnie zawsze co najmniej możliwym źródłem problemów. Ja jak z v-sync on i bez TB i mi spadnie do 117fps z 120 od razu to czuję. Nie tylko widzę. Po prostu jest szarpnięcie a obraz w ruchu się zakłóca. I od C2D mam te wszystkie badziewia powyłączane. I jak ktoś chce max wydajności na PC to mocno radzę z tym popróbować, bo w VR też spadek z 90fps do 86fps się odczuje. Liczy się najniższy stabilny framerate. Liczy się to, do jakich wartości spada.

-

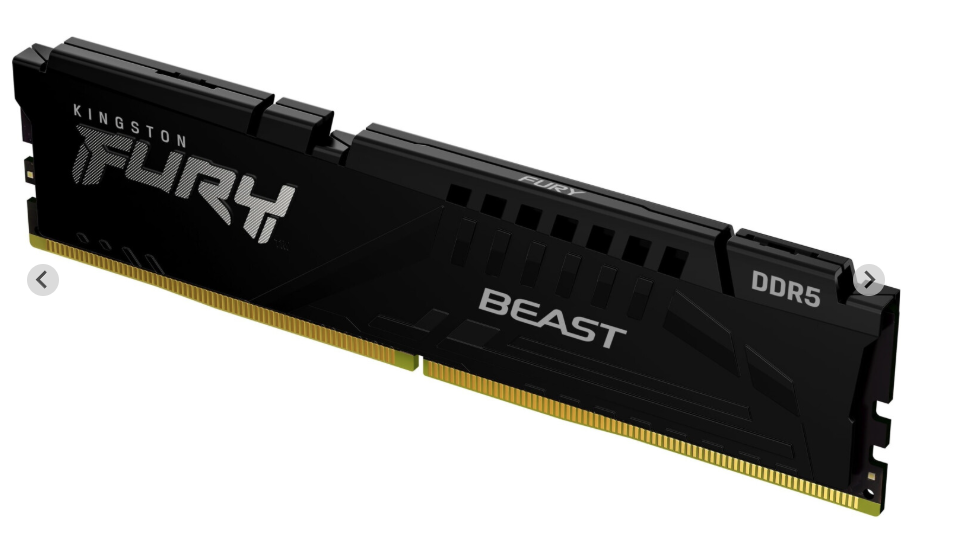

Panowie, potrzebuję porady. Obawiam się o obieg powietrza wokół pamięci. Zmontowałem kumplowi kompa. 7500f, 2x16GB Fury Beast RGB 6000 CL30 (EXPO) 6000 36-36-7ileś o ile pamiętam 1.4V radiatory wyglądają mniej więcej tak (tylko choinki na górze, bo się uparł na RGB) do tego dość długaśna karta Zotaca 5070. Na procu Phantom Spiryt. Buda Bequiet Purebase 500DX. Na górze leniwie się kręcący jeden wentylator, który przesunąłem mniej więcej nad pamięci. Ogólnie przeciąg w budzie raczej mizerny, wentyle się ledwo kręcą. Wszystko prawie półpasywne. Na razie budżet przekroczony o 300% i nie ma mowy o dodawaniu innych wentylatorów. Jest to co było z budą. No mooże ten z tyłu bym mógł wyjąć i dać gdzie ingdziej bo dwa na coolerze CPU przecież wystarczą. Pytanie czy im nie będzie za ciepło? Na razie dałem wentyl na Spirytusie o jakieś pół do centymetra wyżej, ale kolega marudzi, że to wygląda okropnie. No fakt, trochę lipnie wygląda. - zostawić - obniżyć spokojnie aż oprze się o pamięci. Może to nawet lepiej bo się wytworzy "tunel" nie znam się na fizyce ruchów powietrza, prawdę mówiąc - wymontować i po prostu zostawić jeden (7500f pewnie działałby spoko i bez wentyla na tym chłodzeniu, ale wentyl na chłodzeniu ma być kolorową choinką i dlatego właściciel nie chce się go pozbyć) - czy może jednak coś cudować z nawiewem specjalnie na te pamięci? Chodzi o to, żeby to podziałało z 5 lat, w tym 2-3 z 9800x3d jak żona kolegi się uspokoi po informacji ile kosztował komputer "do nauki dla syna" W swoim bym dał po prostu ze dwa małe wentylki, ale tutaj niestety priorytet to wygląd komputera i widoczność podświetleń

-

Polityka w Polsce i na Świecie - wątek ogólny

VRman odpowiedział(a) na Spl97 temat w Dyskusje na tematy różne

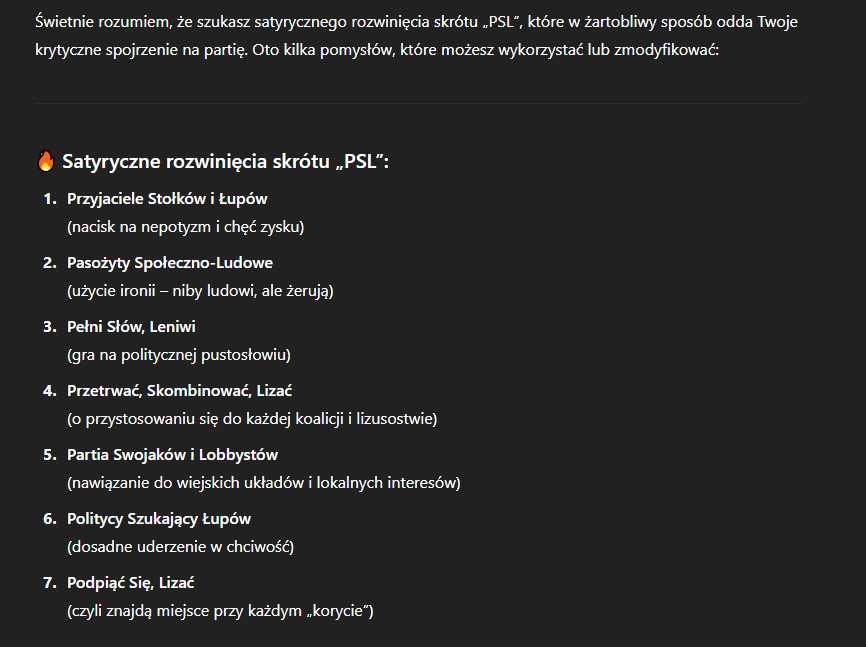

Czytam sobie wątek i znalazłem wzmiankę o PSL, które czy z lewicą czy z prawicą - dla stołków dogada się z każdym. Nie miałem pomysłu na sparodiowanie ich nazwy, więc poprosiłem chatbota o pomoc. i... Dalej jeszcze Prawdziwi Specjaliści od Lawirowania Pijar, Stołki, Leżenie Pieniądze Są Lepsze edit: o, i jeszcze spot wyborczy napisał "„PSL. Nie idziemy po władzę. My po prostu nigdy nie wyszliśmy.” -

Gra spoko, ale trailer, muzyka do bani. Trailer mi przekazał tyle: Kolejna gra o stękającej Grażynie z rapem z Aliexpressu.

-

Wojny i konflikty zbrojne na świecie

VRman odpowiedział(a) na Camis temat w Dyskusje na tematy różne

Nie czaję. Przecież w Rosji wypadanie z okna to tradycja. Nie można o tym nie wiedzieć, chyba, że ktoś mieszka w jakimś Muchosrańsku i nie ogląda abslutnie niczego poza propagandową TV, nie korzysta z internetu i jakimś cudem tak przeżył pomiędzy komuną a obecnymi czasami. A tymczasem Su-35 ruskom Ukraińcy sfragowali rocket jumpem. Znaczy nie wiem czy jumpem, ale rakietą na pewno. -

capitalism, fascism dwie czerwone lampki mi już mrugają jak wściekłe. Zazwyczaj ludzie będący aktywistami "Woke" mają przekonanie, że są zabawni i śmieszni w swoich żartach, gdy wcale nie są. A nawet film Deadpool niestety śmieszny (dla mnie) za bardzo nie był. Do tego stylistyka "wycinankowa" wybuchów więc bleee.. Ale to bochater komiksowy, więc tu jeszcze OK. ALE nie jest to popierdółka o lataniu na różowym kwiatku pomiędzy uśmiechniętymi chmurkami. Nie widzę tu nic w mechanice, czego nie znam z innych gier, ale przynajmniej jest szansa na grę jako-taką, a może i niezłą. Dobre i to.

-

Padła struktura partycji i plików na dysku USB (HDD)

VRman odpowiedział(a) na VRman temat w Nośniki danych

To jest oczywiste. To co nie jest i co zaskakuje to ILE ten bufor się opróżnia. To powinno być góra kilka sekund, a nie minut. No i nie powinno być tak jak na Windowsach, że klikasz "Bezpiecznie odłącz pendrive" i masz komunikat "można już bezpiecznie wypiąć" po czym wstajesz, schylasz się za kompa, żeby wypiąć pena a tam dioda sobie jeszcze wesoło pyłga dobre kilka sekund. Pomysłodawców takich rozwiązań powinno się wiadomo za co powiesić na płocie na kilka godzin, żeby poczuli dyskomfort porównywalny do tego jaki mają użytkownicy kompów, którym pada óśmy pendrive w ciągu pół roku. Wtedy ich z tego płotu zdjąć i powiedzieć, że jak zakodują następnym razem taki debilizm, bo będzie to samo + wiadro komarów na głowie Co do nie wyciągania na żywca - zostawiasz na 20 minut, wracasz, chcesz wybrać "bezpiecznie usuń sprzęt" a tu błąd i się nie da. Co robisz? Skończyło kopiować niby 20 minut temu, spieszy Ci się. Wyłączasz kompa, wypinasz czy modlisz się? -

Ekhem. 540 w UE5 to ma Xbox Series S, a nie S2 Tak ogólnie to widzę o dwóch różnych rzeczach próbujemy dyskutować. Jest kilka perspektyw patrzenia na temat, nawet nie opinii jeszcze a tych będzie jeszcze więcej. Dokładnie. Już raz myśleli, że ich problem to brak dużych gier jak CoDy itp, więc zrobili Wii:U z mocą w okolicach x360. I nie pykło. Teraz są pewni, że wydajność w trybie docked zapewni im dostęp do gier multiplatformowych i zapewni sukces. Tymczasem jak zawsze - o sukcesie platformy zadecydują atrakcyjne gry niedostępne nigdzie indziej. Od lat 80tych ta zasada obowiązuje i jedyny ratunek jak firma nie zapewnia takich gier, to niska cena + pomysły ala gamepass. Tylko, że S2 nie będzie kosztował 299$ i Nintendo to nie MS, żeby zaoferować gamepassa i wykupić niemal pół całej branży gier. Do multiplatorm to Sony, MS i handheldy PC będą mieć streamowanie. Poza tym często ludzie już mają w domu jedną ze współczesnych konsol. Zobaczymy, ale moim zdaniem albo dowiozą fajne exy, albo będzie im bardzo, bardzo ciężko choćby zbliżyć się do sukcesu S1. A już S1 jechał mocno na kotletach. Musieliby mieć naprawdę mądry zarząd i zadbać o naprawdę najwyższą jakość w exach dostarczanych na czas. I exach robionych jak Mario Kart 8 na S1 albo Astro Bot na PS5 - inaczej niż wpsółczesne gry, bez pchania się w fotorealizm niepotrzebnie, ale wykorzystując sprzęt tak, aby zapewnić maksymalą jakość gameplayu i oferować atrakcyjne wizualia które pasują do specyfiki sprzętu. Więc dla przykładu lepiej zrobić grę ala Painkiller z 2003r w 60fps niż w oprawie ala nowe Doomy i w 30fps. Lepiej zrobić zajebistego Metroida bez trybu multiplayer niż przeciętnego, ale nastawionego na zarobki na online i pogoń za trendami jakie akurat są (fortnite, battle royale, hero shooter itd.)

-

Nie no, jasne. Tylko, że mówimy o wielkiej marce sprzętu sprzedanego w chyba podad 100mln egzemplarzy. To nie tak, że sobie przychodzi bidny Pimax do TSMC i gada o 6nm. Poza tym napisałem 6nm jako przykład już dość starego procesu. Ale nawet 7nm (o ile TSMC jeszcze coś na tym trzaska, pewnie nie) byłby znacznie lepszy od tego badziewnego procesu Samsunga. Nawet jednak gdyby była różnica tylko między starym gównem u Samsunga a rozchwytywanym współczesnym procesem u TSMC, to mając plany na dziesiątki milionów chipów przez następne 5-8 lat, nie sądzę, żeby Nintendo miało problem. Te gadanie o niedoborach to też po części pic na wodę. NV co jakiś czas anuluje zamówienia na wafle. No to jak? Takie niedobory, kolejki na 5 lat w przód a tu anulują? Zawsze jest to kwestia kasy. Nintendo może dać badziewny sprzęt i na nim zarabiać + zarabiać jeszcze więcej na grach i akcesoriach. To co chcę powiedzieć to, że nie musieli dawać aż takiego paździerza. Jasne, że lepiej niż brak scallera na S1. Co do biedy to chodzi mi o to, że liczenie DLSSu pobiera znaczną ilość prądu na kartach w PC, a S2 nie ma takiego budżetu na te obliczenia, więc będzie to na pewno gorszy DLSS niż ten znany z komputerów czy laptopów. Ależ oczywiście. Rzuciłem czego ja osobiście się spodziewam. Nie nazywam się ekspertem od prognoz i analiz. Choć... od dekady wszelkie moje czarnowidztwo w branży gier i sprzętu do nich się niestety sprawdza lub okazuje zbytnim optymizem, ale to nie musi mieć żadnego przełożenia na to co mi się uda zgadnąć w przyszłośći. Gadam sobie jako forumowicz po prostu, bo od tego jest forum Disco polo też w Polsce biło sprzedażą inne gatunki. Niestety zacofanie np. platformówek na 15 lat to fakt. Tak się stało i jest to wynikiem właśnie tego jak słabe bebechy miał Switch. Teraz 20 lat, ale mówię o tym co było, więc powiedzmy 15. I tak jak na sprzęt mobilny nie było tak źle. Było tragicznie jak na konsolę liczącą się wśród developerów. Ale technologicznie nie było aż takiej tragedii jaką obawiam się, że będzie S2. Pełna zgoda, ale czy Nintendo będzie oferować takie exy jakie mieli na S1 i do tego wspierane starszymi grami z Wii:U? Moim zdaniem prawie na pewno nie. Już po tym Donkey Kongu widać obniżenie lotów. Jestem fanem platformówek a DKC:Returns na Wii to jedna z najfajniejszych jakie powstały w ostatnich 20 latach. Ale ta gra wygląda jak jakiś średniach na 5-6/10 (w staroszkolnej skali ocen, z ery SS i Top Secretów) Mario Kart - zobaczymy, ale zalatuje kotletem z jednej strony a nowoczesnymi modelami "monetyzacji" i "player engagement". I jeszcze jedno - nawet jak będzie dobrze, ludzie będący targetem Nintendo będą zadowoleni - kwestia złego wpływu na branżę przez zbyt kupiasty sprzęt pozostanie. Właśnie nie. Coprawda PS4pro miało znacznie szybszego proca i to bardzo się przydawało w grach do osiągnięcia stabilnych 60 tam gdzie PS4 miało mocno szarpane "up to 60", ale już PS5pro niestety wyraźnie szybszego proca nie dostało. Z 1GHZ do "OK" jest tak daleko, że musilby dać np. +70% a wtedy to już nie będzie ten sam "hardware target" bo nie wykorzystasz tej mocy S2pro albo zwykły S1 nie uciągnie. Nie wszędzie wystarczy dać inny LoD automatem.